-

Compteur de contenus

388 -

Inscription

-

Dernière visite

-

Jours gagnés

2

Tout ce qui a été posté par Amsonia

-

MailPlus : reverse DNS Free non fonctionnel et rejet de mails par certains serveurs

Amsonia a répondu à un(e) sujet de adelac dans Installation, Démarrage et Configuration

Bonjour à tous, Je me permets de déterrer ce fil car je suis malheureusement dans la même situation. Un de mes NAS est sur une ip fixe Free de l'ancienne mode : reconnue par tous comme une ip fixe, avec un rDNS fonctionnel. Mon autre serveur a récemment été basculé sur une nouvelle ip fixe par free, sur leur nouvelle infra : ip reconnue comme faisant partie d'un pool d'ip dynamiques et rDNS non fonctionnel (actif selon mon espace abonné free.fr mais non effectif dans la réalité). Je rencontre donc les mêmes problèmes que vous tous : emails refusés sur le réseau microsoft et ce, même si je fais passer tous mes mails par le serveur dont l'IP est "propre". Microsoft doit probablement voir que l'un de mes enregistrements MX pointe sur une IP "sale". Évidemment, mes enregistrements SPF, DKIM, DMARC sont a priori corrects (10/10 chez mail-tester.com) Bref, je recherche donc un relai SMTP performant, en Europe de l'ouest et peu cher. J'ai bien vu Mailjet mais 13,60€/mois pour envoyer environ 200 e-mails par mois, ça fait un peu cher. -

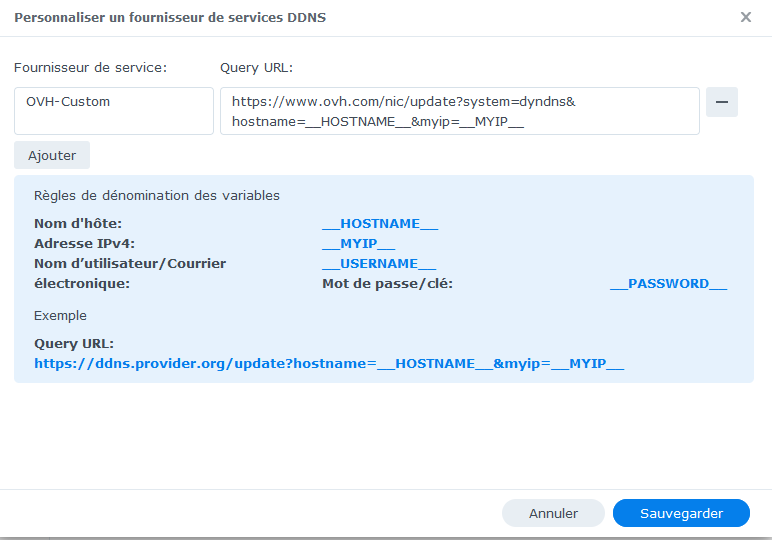

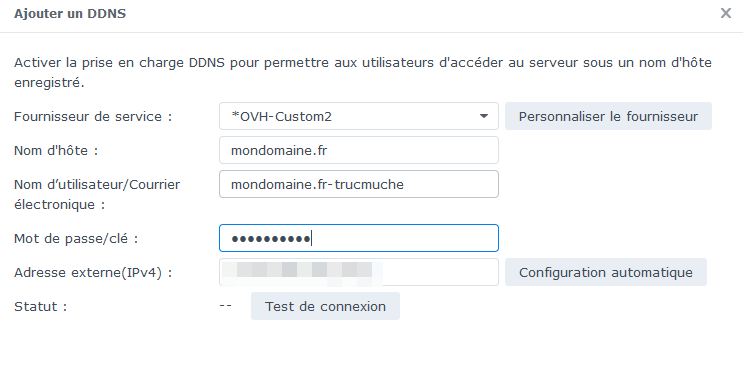

Bonjour, Je dispose de plusieurs domaines, chez OVH en l'occurrence, que je souhaitais faire pointer sur mon NAS. Pour le premier domaine, pas de soucis, je rentre la configuration DynOVH et le tour est joué mais quid pour les autres ? En effet, Synology interdit, pour je ne sais quelle obscure raison, d'utiliser plusieurs fois le même DynDNS. Je me retrouvais alors à faire un montage sale au niveau de la zone DNS de ce deuxième domaine pour qu'il pointe vers le serveur. Cela fonctionnait mais ce n'était pas propre et puis, illumination : le fournisseur DDNS personnalisé ! C'est extrêmement bête mais il suffit en effet de créer un "fournisseur personnalisé" de DDNS avec la bonne URL de requête vers OVH et le tour est joué. Le plus beau là-dedans, c'est que l'on peut créer plusieurs configurations personnalisées ! Donc si j'ai 6 domaines chez OVH, il me suffit d'utiliser le DynOVH de DSM pour le premier et puis de créer 5 "configurations personnalisées" sur la même URL et tout fonctionne proprement 🙂 Comme on le voit ci-dessus, l'adresse de requête est : https://www.ovh.com/nic/update?system=dyndns&hostname=__HOSTNAME__&myip=__MYIP__ On n'a pas à insérer les variables relatives à l'identifiant ni au mot de passe, en tout cas pas avec DynOVH. Ensuite, il suffit de sélectionner notre fournisseur "OVH-Custom" dans la liste pour ajouter un DDNS. La page de documentation OVH pour ce service : https://docs.ovh.com/fr/domains/utilisation-dynhost/

-

2

-

[RESOLU] Reverse proxy qui renvoie sur le DSM

Amsonia a répondu à un(e) sujet de Amsonia dans Installation, Démarrage et Configuration

@adelac tu veux mon retour d'expérience sur quoi en fait ? 🙂 Mon post https://www.nas-forum.com/forum/topic/59108-tuto-reverse-proxy/?do=findComment&comment=1319453680me semblait plutôt clair et complet sur le sujet..- 15 réponses

-

1

-

- resolu

- reverse proxy

-

(et 1 en plus)

Étiqueté avec :

-

[RESOLU] Reverse proxy qui renvoie sur le DSM

Amsonia a répondu à un(e) sujet de Amsonia dans Installation, Démarrage et Configuration

Merci @oracle7 pour ta réponse. Je suis allé faire un tour sur le tuto dont tu parlais et, effectivement, il me manquait l'étape de redirection par htaccess de http vers https...sauf que ça ne fonctionnait toujours pas. Réponse complète illustrée mà-bas :- 15 réponses

-

- resolu

- reverse proxy

-

(et 1 en plus)

Étiqueté avec :

-

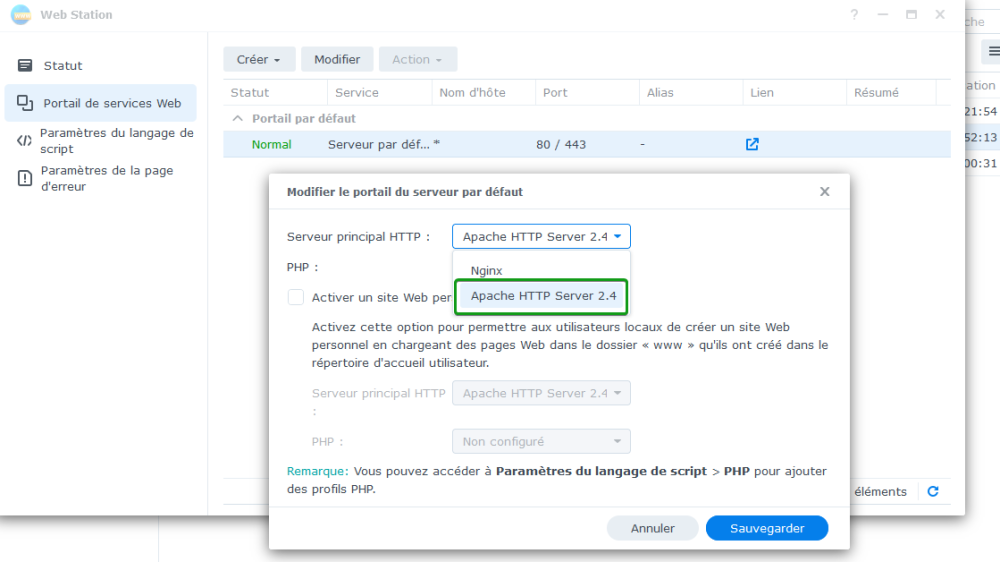

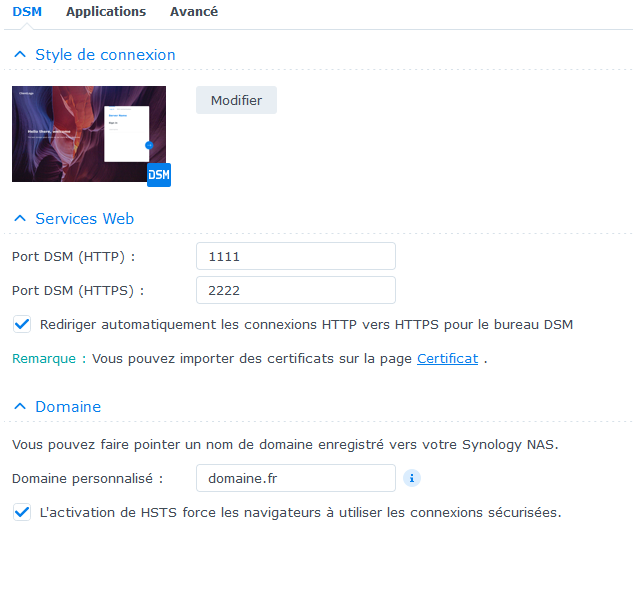

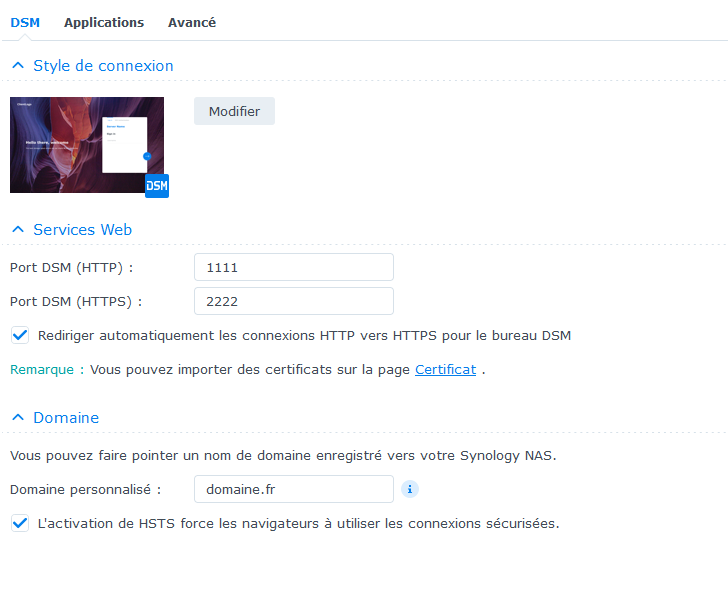

Bonsoir, Je me permets d'apporter ma petite pierre à l'édifice, dont @Kawamashi pourra peut-être tirer avantage. Pardon d'avance si les informations ci-dessous sont déjà présentes dans les 60 pages de ce fil, j'avoue ne pas les avoir parcourues... Mon soucis portait sur la mise en place d'une redirection par htaccess de HTTP vers HTTPS, de sorte que lorsque l'on tape machin.domaine.fr (sans http://) on soit renvoyé vers https://machin.domaine.fr et non vers le DSM en HTTPS. Sous DSM7 donc, inutile apparemment de créer un "site web personnel", inutile également d'installer deux versions du serveur web Apache. Je me suis contenté d'installer la version la plus récente, soit la 2.4 à l'heure où j'écris ces lignes. J'ai utilisé ces lignes plutôt que celles proposées dans le tuto : RewriteEngine On RewriteCond %{HTTPS} off RewriteRule ^(.*)$ https://%{HTTP_HOST}%{REQUEST_URI} [L,R=301] Mais surtout, j'ai réalisé que le serveur web utilisé par défaut était nginx et non Apache et, d'après ce que j'ai cru comprendre, Nginx ne sait pas lire les htaccess. Des redirections vers https sont bien possibles avec nginx mais il aurait apparemment fallu modifier des fichiers de configurations dans les entrailles du NAS. La seule manipulation que j'ai eu à faire fut donc de basculer de nginx à apache pour que la redirection soit effective. Enfin, et je pense que cela pourra intéresser du monde, mon reverse proxy et ma redirection fonctionne parfaitement avec le HSTS activé (que ce soit pour le domaine personnalisé de DSM ou pour les sous-domaines gérés par reverse proxy) ainsi qu'avec la redirection http vers https pour le DSM. Autrement dit, ça fonctionne avec cette configuration : J'espère avoir été relativement clair ! 🙂

-

[RESOLU] Reverse proxy qui renvoie sur le DSM

Amsonia a posté un sujet dans Installation, Démarrage et Configuration

Bonjour à tous, J'utilise un domaine personnalisé (appelons-le domaine.fr) sur mon nas (sous DSM 7) ainsi que le proxy inversé pour gérer différents sous-domaines qui pointent sur différents services, des containers docker en l'occurrence. Globalement, tout fonctionne bien si ce n'est que je suis parfois renvoyé sur la page de connexion de DSM au lieu d'arriver sur le site demandé. Plus précisément : Cas1 : je demande "https://sub1.domaine.fr", ça fonctionne. Le NAS me sert le bon site. Cas 2 : je demande "http://sub1.domaine.fr", ça renvoie sur la page de connexion de DSM, et l'URL a été changée par "https://sub1.domaine.fr:2222 " où 2222 est mon port personnalisé de connexion DSM en https. Mon DSM est configuré pour être accédé à la racine du domaine, sans avoir à spécifier de port dans l'URL, soit https://domaine.fr Les ports 80 ; 443 ; 1111 et 2222 sont redirigés du routeur (freebox) vers le nas, c'est tout. Cas 3 : je demande "sub1.domaine.fr", le comportement est le même qu'au cas 2. Le comportement souhaité serait que j'arrive sur "https://sub1.domaine.fr" dans les trois cas. Voici des captures de la configuration- 15 réponses

-

- resolu

- reverse proxy

-

(et 1 en plus)

Étiqueté avec :

-

Connaître les processus générant un traffic réseau + destination

Amsonia a répondu à un(e) sujet de MilesTEG1 dans Installation, Démarrage et Configuration

Bonjour, Je me permets d'intervenir ici car je pense avoir le même besoin ou du moins la même volonté que @MilesTEG1. Pour moi, l'idée est de pouvoir déterminer très rapidement quel paquet ou quel container docker est responsable de tel ou tel trafic entrant ou sortant. Par exemple, si je note une hausse de l'upload dans le graphe du Moniteur d'activités, je souhaite savoir s'il s'agit de quelqu'un qui est en train de parcourir des photos/vidéo sur SynoPhotos, s'il s'agit d'un visionnage de film depuis le container Plex, si c'est mon container Transmission qui envoie des données, si quelqu'un est en train d'envoyer de gros mails (...) ou bien évidemment me mettre sur la piste d'une potentielle intrusion ; donc scénario où un étranger serait en train de sucer le serveur... Idem, dans l'autre sens, pour le trafic descendant évidemment. Dans mes souvenirs, Darkstat ne permet pas exactement de faire cela. Darkstat nous montre tout le trafic entrant et sortant, avec les IP responsables de ce trafic mais Darkstat ne nous indique rien concernant l'application qui serait la cible ou la source dudit trafic. D'un autre côté j'ai survolé le tuto https://www.nas-forum.com/forum/topic/63273-tuto-monitoring-nas-et-réseau/ mais, si ça semble très puissant (et très joli) je ne sais même pas si ce trio d'applications pourrait combler mes attentes. Idem concernant NetData -

[TUTO] Plex via docker, avec ou sans transcodage matériel

Amsonia a répondu à un(e) sujet de Einsteinium dans Tutoriels

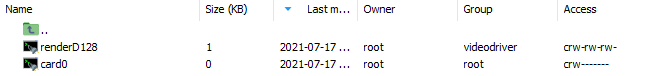

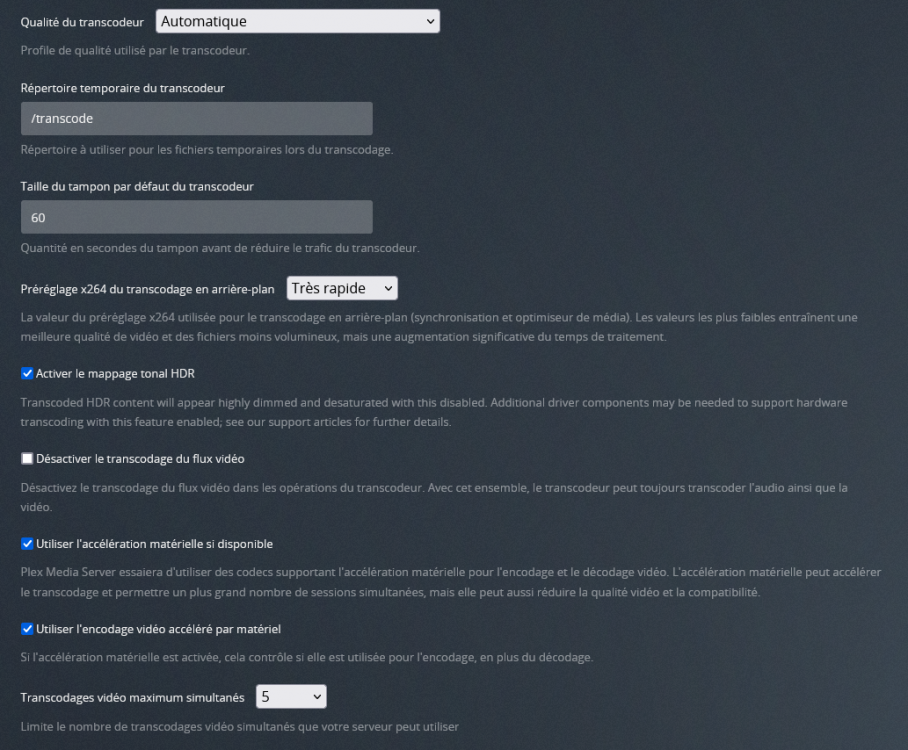

Il y a probablement quelque chose que j'ai du faire à côté de la plaque car je ne vois pas le '(hw)' quand je force un transcodage. Je lis depuis http://app.plex.tv, sur le même LAN que celui où est le NAS. J'ai le plexpass si jamais cela a une importance quelconque. Voici le fichier que j'ai importé pour re-créer le container. On y voir bien les lignes nécessaires même si, comme dit, j'ai du les ajouter purement et simplement. plex.syno.json Comme dit précédemment, le json exporté ne contenait pas les lignes suivantes "ddsm_bind_share" : "", "devices" : [], Et comme on le voit ci-dessous, mon /dev/dri/renderD128 a bien été chmodé en 666. Par ailleurs, voici une capture d'écran de ma configuration de transcodage au sein de Plex : Enfin, voici une capture vidéo du moniteur de ressources CPU dans Plex : https://www.fromsmash.com/plex Le premier plateau correspond au lancement du transcodage du film puis on voit que ça se calme avec l'utilisation par Plex aux alentours de 30% de CPU (ligne verte). Le second plateau correspond au moment où j'ai fait un gros saut dans la lecture de la vidéo : le système a du se reconstituer un cache d'images transcodées, puis ça se calme à nouveau. Ce comportement correspond-il au transcodage matériel ? -

[TUTO] Plex via docker, avec ou sans transcodage matériel

Amsonia a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour, Je viens d'installer le container plex en suivant les instructions, ça fonctionne ; merci encore pour ce beau tutoriel. Néanmoins je bloque à l'étape d'activation du transcodage matériel. Je parviens sans problème à chmoder /dev/dri/renderD128 et le script est en place pour s'exécuter à chaque redémarrage par l'user root. En passant, j'ai aussi un /dev/dri/card0 ; à quoi ça correspond ? On doit lui appliquer un chmod 666 aussi ? En revanche, impossible de trouver trace de ces lignes dans mon fichier de conf .json. "ddsm_bind_share" : "", "devices" : [], J'ai donc pris le parti d'ajouter les lignes nécessaires juste après celle visant la priorité de cpu mais les lignes ne sont pas conservées par docker ! En effet, si j'importe le json, lance le container et re-exporte le json, mes éditions ont disparues et je me retrouve au point de départ 😞 A toutes fins utiles, j'attache le json tel qu'exporté et celui que j'importe. Je précise que je modifie le json soit via l'éditeur de texte de dsm soit via sublimetext donc, normalement, je n'importe pas de fichier foiré. plex.syno.json_edited plex.json_original -

Quand tu dis "distant", ça veut dire "via internet" (même au sein d'un VPN ?) ou même distant au sens d'un réseau physiquement local ? Sinon et pour revenir à mes questions, vous n'avez pas émis de contre-indication majeure à la capacité de fonctionnement de ce schéma d'infra. Mais est-ce fondamentalement la meilleure solution ? N'aurai-je pas intérêt à mettre les mails sur un R.Pi par exemple. La grande inconnue pour moi c'est vraiment la réactivité du système. Je n'ai pas envie de claquer ~1500€ pour des bouzins qui rament à lancer DS Vidéo et streamer sur la TV un film en 1080p ou bien à ouvrir plusieurs instances de MailPlus avec du torrent qui tourne h24 et des tâches hyperbackup qui crunchent toutes les nuits...

-

Je pensais à un NAS double baie pour rester relativement peu cher par rapport à un (ou deux si réplication à distance) nouveaux NAS à 4 baies et surtout parce que, dans tous les cas, les CPU sont très faiblards donc je prends le parti de renouveler plus souvent par du petit matériel plutôt que de renouveler moins souvent par du matériel plus gros et cher. Quant à la piste des SSD, ce serait pour gagner en réactivité car, actuellement, l'affichage de DS Video met des plombes, l'utilisation de Mail Plus est quasiment impossible, etc. Les disques de mon 412+ grattent tout le temps pour pas grand chose, y compris quand je ne fais pas du torrent et qu'il n'y a que 1ou 2 personnes sur le serveur. Je vois ton point sur le fait de mettre une unité d'expansion en volume dédié ; c'est ce que je pensais faire d'ailleurs. Du coup, le fait que le 718+ puisse gérer un DX517 comme expansion du volume principal en plus de pouvoir le gérer comme nouveau volume, n'a effectivement que peu d'intérêt.

-

Bonjour à tous, J'ai actuellement un DS410 et un DS412+ en des lieux distants. Le DS410 me sert aujourd'hui principalement à accueillir les sauvegardes et le DS412+ est mon matériel principal. Or ce dernier commence sérieusement à ramer pour mes usages et je songe à faire évoluer le tout, en partant sur du NAS et/ou du R.Pi ou équivalent et/ou du VPS OVH. Les besoins logiciels : serveur mail (MailPlus) pour au moins 4 personnes sur 2~3 domaines synoDrive ou équivalent vers et depuis une dizaines de devices (ordi, tablettes, smartphone...) suite bureautique serveur web (sites perso, agrégateur rss, etc.) serveur sftp/ssh moments photostation videostation ou équivalent audiostation torrent hyperbackup Besoins un peu moins importants : serveur vpn serveur dns Les contraintes de sécu : redondance (de données) locale redondance (de données et d'applications) distante J'ai symbolisé en vert les données et services qui seront sollicités le plus souvent, en rouge les données/services plus lourds et sollicités moins souvent, en orange le truc bâtard et en noir les outils admin. J'envisage de mettre le vert et le rouge chacun sur des machines dédiées. Par exemple machine principale : DS218+ ou DS718+ avec une paire de SSD 1To en RAID1 et boosté en RAM Cette machine gère le vert ainsi que l'applicatif du orange et le noir. machine de stockage : soit une extension type DX517 soit une reconversion de mes NAS actuels (DS410 et DS412+) qui stockeraient ainsi les films, les musiques, les photos archive : tout le rouge. Certaines de ces données seraient accédées pour du bittorrent (orange) mais l'application (transmission dans mon cas) serait installée sur le nas principal. Un truc comme cela (DS718+ lié à DS412+ d'un côté et DS718+ lié à DS410 de l'autre côté) me reviendrait apparemment à 1490€ ttc soit ~260€/an si l'on considère un renouvellement tous les cinq ans. Ce n'est pas insurmontable mais ce n'est quand même pas rien, surtout quand on voit que Syno délaisse le grand public pour aller vers le vrai pro et qu'en même temps on a toujours des cpu anémiques dans ces machines. D'où mes questions : Outre le prix, est-ce que la configuration décrite serait fonctionnelle selon vous ? Si oui au point précédent, et en prenant en compte le prix cette fois, pensez-vous mon idée soit la plus pertinente ou bien aurai-je intérêt, par exemple, à prendre deux R.Pi (pour failover distant) et à leur mettre YUNOHOST dessus pour tout ou partie de mes besoins rouge ? Autre idée de structuration ?

-

Bonsoir à tous, J'ai du faire quelques malencontreuses modifications de permissions je ne sais où et résultat, j'ai mon photostation qui débloque partiellement. Par exemple, je ne télécharge qu'un fichier de 38 octets quand je souhaite télécharger une photo récemment sauvegardée automatiquement depuis mon smartphone. Autre exemple, la sauvegarde de mes photos sur un nas distant, via hyper backup ne fonctionne plus. Dernier symptôme dont j'ai pu me rendre compte : des vignettes grisées et des albums qui disparaissent alors que mon compte est admin. Je crois que j'ai du me mélanger les pinceaux sans le vouloir :-s Quelqu'un pourrait-il donc me dire quels sont les droits d'origine corrects au niveau des utilisateurs système et des utilisateurs humains pour : l'application photostation en elle-même le dossier partagé /volumeX/photo et ses sous-dossiers le dossier /volumeX/homes/user/photo/ et ses sous-dossiers Merci beaucoup !

-

Vitesse de transfert & logs backup

Amsonia a répondu à un(e) sujet de Amsonia dans Sauvegarder et Restaurer

Les deux NAS n'ont pas d'IP fixes mais ce n'est pas le souci. Ça crashe bien avant le renouvellement des IP. -

Vitesse de transfert & logs backup

Amsonia a répondu à un(e) sujet de Amsonia dans Sauvegarder et Restaurer

La connexion du NAS source est stable. Celle du NAS destination également, c'est la connexion SSH qui timeout régulièrement, pas la connectivité internet en elle-même. Et je ne sais pas où trouver plus d'informations à ce sujet. -

Vitesse de transfert & logs backup

Amsonia a répondu à un(e) sujet de Amsonia dans Sauvegarder et Restaurer

J'ai donc résolu mon problème de vitesse mais reste toujours le souci des timeout. Voici ce que je trouve dans /var/log/messages du NAS_source quand ça plante : Nov 27 04:15:11 Goldorak rsync: [sender] io timeout after 600 seconds when processing (DOCUMENTAIRES/03 - AERO-SPATIAL/En.Quete.De.Vie.Extraterrestre.E01[ARTE]DOC.FRENCH.HDTV.XVID-JSTS.avi) -- exiting Nov 27 04:15:12 Goldorak synonetbkp: rsync_wrapper.cpp:704 Failed to execute rsync command. source=[/volume1/video/DOCUMENTAIRES], target=[admin@81.XXX.XXX.XXX::NetBackup/Goldorak_3/video/], ret=30 Nov 27 04:15:12 Goldorak synonetbkp: netbkp_upload_share_data.cpp:118 Failed to execute rsync command. Nov 27 04:15:12 Goldorak synonetbkp: netbkp_backup_data.cpp:52 SYNOBkpUploadCurrentShare() fail. Nov 27 04:15:12 Goldorak synonetbkp: backup.cpp:698 SYNOBkpBackupData() failed, err = 8 Nov 27 04:15:14 Goldorak synonetbkp: Backup task [Network Backup Set 3] completes with result [8]. Time spent: [4263 sec]. [A M P T] in Byte and Count Nov 27 04:15:14 Goldorak synonetbkp: size[804253608377, 721589334189, 0, 0] count[2643, 2131, 0, 0] dir[274, 238, 0, 0] reg[2643, 2131, 0, 0] -

Vitesse de transfert & logs backup

Amsonia a répondu à un(e) sujet de Amsonia dans Sauvegarder et Restaurer

erf, je viens de comprendre la vitesse faible : pour une raison inconnue, la merdouille de box numericable plafonne à 30Mb/s en down au lieu des 100 Mb/s du contrat… -

Vitesse de transfert & logs backup

Amsonia a répondu à un(e) sujet de Amsonia dans Sauvegarder et Restaurer

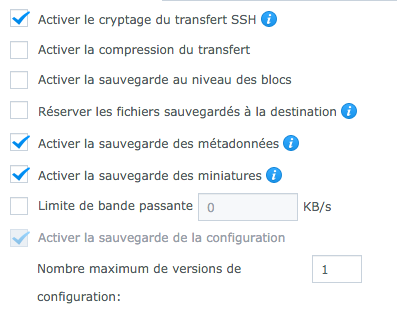

Les données ne sont pas chiffrées a priori, seul le tunnel SSH l'est. Les CPU des deux NAS oscillent entre 3~5% (source) et 25~35% (destination) donc ça, il y a de la marge. Poids fichier : c'est aussi ce que je me suis dit sauf que je suis sur des transferts de fichiers variant entre 25 et 50Mo actuellement. Et le transfert tourne autour de 2 Mo/s seulement. À titre de comparaison, quand j'envoie ces mêmes fichiers sur hubic, je tapais les 15 Mo/s facilement. Et dans ce dernier cas, il y avait chiffrement au préalable ! Quant au mode de backup, je suis resté avec les options par défaut (voir screenshot) donc a priori rien de ce que tu mentionnes. Quant aux logs, c'est dommage mais je ne vais pas passer par du rsync à la main. Je vais seulement bien prendre mon temps pour le backup initial et ensuite ça devrait aller mieux… -

Bonjour, J'ai paramétré des sauvegardes de données et d'applications entre deux Syno distants et j'ai quelques questions : Vitesse de transfert Le NAS source est sur une fibre qui a 250 Mb/s d'upload. Le NAS destination est sur une connexion qui a 100 Mb/s en réception. Pourtant les transferts ne dépassent jamais 4 Mo/s (soit 32 Mb/s) dans le meilleur des cas. Est-ce le fait de passer en SSH qui ralentit à ce point ? Si oui, quelle autre solution me permettrait d'aller un peu plus vite ? Logs de la sauvegarde La connexion s'établit entre une livebox fibre (source) et une box numericable (du câble). Durant mes tests actuels, les deux boxs ne font quasiment que ça -donc très faible charge- et pourtant j'ai régulièrement des timeout sur la destination. J'aimerais suivre cela d'un peu plus près afin de mieux comprendre mais je ne trouve nulle part le log exhaustif du processus. J'ai bien quelques messages (les plus critiques) dans /var/log/messages mais c'est trop succinct ; je cherche un truc qui me dise quel fichier est en train d'être envoyé, quel fichier est terminé, etc. Une idée où je pourrais trouver ça ? Merci !

-

De mon côté, l'admin parvient bien à se connecter, le checkinstall me dit que je suis à jour (v1.2.4) mais BBS ne dispose pas d'un mode "guest". Autrement dit, on ne peut pas visiter mon BBS comme n'importe quel site web. Il faut que moi -admin- crée manuellement un compte pour chaque utilisateur. Que dois-je faire pour proposer ma librairie d'ebooks en libre accès ?

-

Apparemment la solution a été trouvée ici : http://blogmotion.fr/systeme/indexer-media-11535

-

Relicats, Purge De La Base D'audio Station?

Amsonia a répondu à un(e) sujet de Thesalan dans Audio Station

En cours de test, merci d'avoir partagé ce tutoriel ! Si ça s'avère efficace, je crois qu'il faudrait épingler ce topic !!! -

Merci pour la réponse, en effet cela fonctionne. Mais à moins de l'exécuter manuellement et sur un sous-sous-sous-dossier bien précis de volume1/music, j'avoue que je n'aime pas trop la technique. En effet, cela engendre une intense activité disque dur et quand on a plusieurs centaines Go de musique, on entend "gratter" les disques pendant longtemps. Je doute que cela ne soit très bon pour la durée de vie des disques :-s

-

Bonjour, Malgré les mises à jour de DSM et d'AudioStation, il y a toujours un comportement qui me gêne : AudioStation n'indexe pas tous les morceaux ! Ou, plus précisément, AS ne va pas indexer des dossiers qui sont créés par Transmission (avec les droits relatifs) dans le dossier music. Un membre du forum avait créé un petit script pour forcer l'indexation incrémentale pour contrer ce comportement, mais je ne le retrouve plus. En attendant, on est obligé soit de lancer une ré-indexation globale des fichiers multimédia (soit plusieurs heures à dizaines d'heures) soit désinstaller puis réinstaller audiostation. Quelqu'un aurait une solution définitive pour que l'index d'AS soit toujours bien à jour ? Merci

-

Droits Sur Photo Station Personnel

Amsonia a répondu à un(e) sujet de Amsonia dans Photo Station + Videos + Blog

Le dossier "photo" général est à la racine du volume oui mais là je parle du photostation personnel de chaque utilisateur. Lequel est alors dans son dossier home personnel donc c'est bien /volume1/homes/admin/photo