-

Compteur de contenus

2944 -

Inscription

-

Dernière visite

-

Jours gagnés

76

Tout ce qui a été posté par MilesTEG1

-

@.Shad. @Jeff777 Merci pour vos réponses. Du coup j'ai regardé ces volumes inutilisés, et c'est toujours ce chemin (sauf le hash shamachin) : /volume1/@docker/volumes/d2d56f5985e73307f1d1501e99005a257a552fe26eeed4a698394f58b485a269/_data Du coup faut que je me tape tous les dépôts pour identifier dans les fichiers dockerfile celui qui me fait ce dossier _data. J'ai ceci comme conteneur, si vous savez lequel utiliser le dossier _data avant que j'ai fini de parcourir les dépôts 😄

-

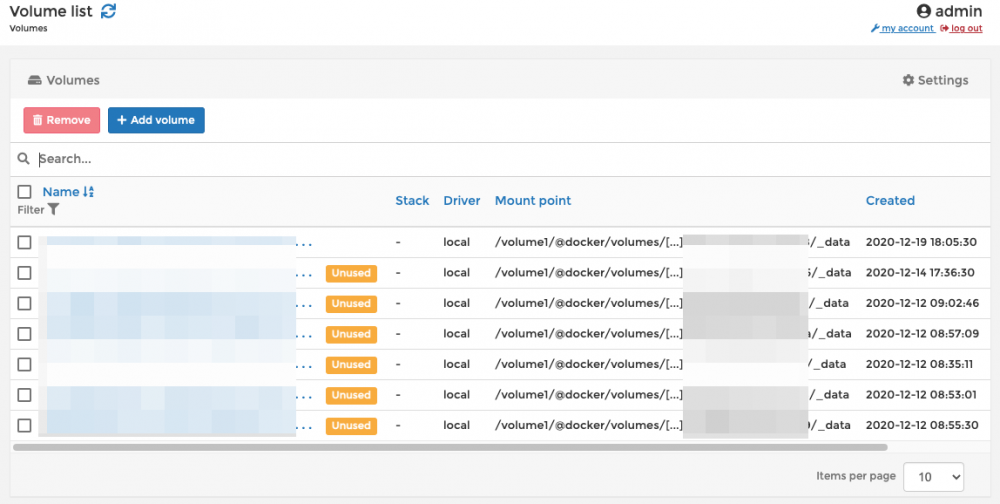

Hello, J'ai depuis quelques temps ces messages, dans des emails séparés : Found multiple running watchtower instances. Cleaning up. Stopping /tKFQbnQXXXXXXXXXXXXXXXXppgUWf (69551232a9dd213522f87000000000000000000009199c6c9e71ac506e71bd) with SIGTERM Removing image sha256:2ddeb26d6d30132b5XXXXXXXXXXXXXXXXXb16a08a8e7efba947cd84fc1 Starting Watchtower and scheduling first run: 2021-01-11 20:00:00 +0100 CET Pourquoi ça me dit qu'il y a plusieurs instance de Watchtower en cours ?? Comment le vérifier ? et faire en sorte qu'il n'y en ait qu'une seule ? Et aussi, j'ai toujours des volumes non utilisés : Alors que normalement j'ai mis ce qu'il fallait dans le docker-compose pour que ça supprime les volumes inutilisés : Si vous avez des idées ^^

-

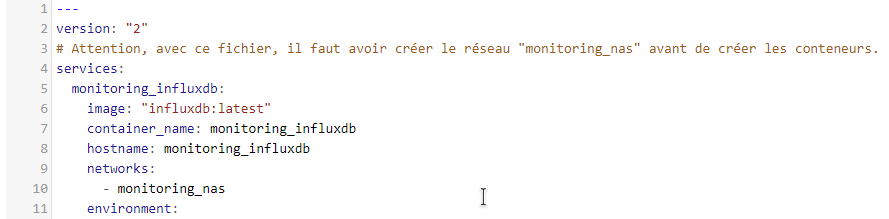

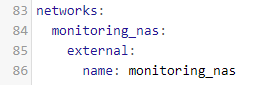

Moi j'ai ça qui fonctionne bien : Je constate aussi que dans ton fichier @Lestat69, tu sembles avoir mis 4 espaces pour chaque "tabulation"... Je ne sais pas si ça ne serait pas mieux avec seulement 2.

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

@Lestat69 Dans ta capture, il semble y avoir un _ après le nom du réseau, ça pourrait venir de là.

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

@Lestat69 tu as bien créé le réseau monitoring avant ?

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Ok merci ^^

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Ok merci 🙂 Juste comme ça, et je sens que vous allez me dire que ça a été dit avant, mais comment vous faites la correspondance entre le n° et le nom du serveur ?

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

@bruno78 ça doit être fastidieux de faire les mappings si tu en as beaucoup 😆

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Ok 🙂 Juste des captures ^^

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

@.Shad. J'essaye de te faire quelques captures cette après midi, j'ai un peu zappé ta demande 😇😇 Je te partagerais ausis mon dashboard (sans speedtest car j'ai pas encore mis ça en place 😉 )

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Je pense que le post de @bruno78 mérite un topic Tuto à part entière 😇

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

J’allais dire la même chose. Je peux aider sur l’utilisation simple de GitHub 😁

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Quelle messagerie 'instantanée' de type WhatsApp (ou autre) utiliser ?

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Installation, Démarrage et Configuration

Ha ok 🙂 Bon bah faut que je trouve autre chose. On me conseille ailleurs : Signal https://signal.org/fr/ Je ne connais pas, c'est bien ça ? Y a pas de failles de sécurité ? -

Quelle messagerie 'instantanée' de type WhatsApp (ou autre) utiliser ?

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Installation, Démarrage et Configuration

Ha oui en effet... faut que l'app soit dispo sur les Stores ^^ -

Quelle messagerie 'instantanée' de type WhatsApp (ou autre) utiliser ?

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Installation, Démarrage et Configuration

Haa j'ai oublié un critère : faut pas que ce soit complexe à installer pour les utilisateurs sinon ils ne voudront jamais bouger 😄 @.Shad. Merci , je vais aller voir ce que c'est. Ha, encore un autre critère : utilisable avec un client gratuit, sur iOS, Android, macOS, windows. -

Bonjour,🙂 Est-ce que vous connaissez une bonne application de Chat qu'on peut mettre en place sur le Syno avec Docker pour remplacer les apps actuelles qui vont devenir encore plus bavardes vers FB... ? (je pense notamment à WhatsApp...) edit : sachant que l'app Chat de Synology possèdes des failles non corrigées depuis un moment... et que ça ne me semble pas me convenir totalement dans le sens où les utilisateurs doivent avoir un compte sur le NAS... Je préfèrerais des comptes liés à l'application sans être dans le NAS. Merci d'avance

-

Moi aussi 😄

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Préparation des disques avant l'utilisation

MilesTEG1 a répondu à un(e) sujet de Lapin dans Installation, Démarrage et Configuration

Oh ! Je n'avais pas vu ce sujet ! Si je l'avais vu je t'aurais répondu plus tôt @capitainealbator Le soucis que tu rencontrais (je mets au passé car vu la date de ton message, j'espère que tu as pu trouver l'info ailleurs...) c'est que que le 920+ les disques ne se nomment pas comme avant... C'est avec /dev/sata1 ou /dev/sata2 . D'ailleurs c'est visible dans le fdiskl -l que tu as posté. 😇 -

Oh ! Ça me plait ce système de "row" 😄 pour les données envoyées à Ookla, je pense que ce sont les mêmes quelque soit le conteneur, et je dirais même que ce sont les mêmes via les applications windows/macos, ou via le site internet, non ?

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Faire une synhtèse 😅 ce à quoi je ne suis pas vraiment doué 🤣 (et dire que je demandes à mes élèves de me faire des fiches bilan...

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Je reste de l'avis de @babble sur l'utilisation du -w pour tester ses disques. Je ne pense pas qu'il dise n'importe quoi... On peut avoir des avis différents, mais ça ne justifie pas ce nettoyage de topic si la discussion est constructive et argumentée (bon après je n'ai pu lire que ce que j'ai reçu dans les notifications emails de cette nuit...). Je suis aussi d'accord sur le fait de ne pas diaboliser cette option -w dans le tuto... ce serait bien d'en tenir compte.

-

Migration DS214 play vers DS220+

MilesTEG1 a répondu à un(e) sujet de patamel dans Installation, Démarrage et Configuration

@aj13fr Il se peut que la migration soit quand même possible... Je ne me rappelle plus ce que j'ai fait quand je suis passé du 214play au 920+ cet été... Je ne souhaitais pas faire de migration car je voulais passer sur du BTRFS, et du SHR sur deux disques, donc migration impossible. Mais s'il veut vraiment ne pas tenter une migration hasardeuse, il est souhaitable de passer les disques par la case formatage depuis un ordinateur. Ou bien depuis le 214play, c'est faisable, mais faut d'abord sortir le disque du groupe de stockage, et après il y a une option pour l'effacer entièrement. Voir ici : https://www.synology.com/fr-fr/knowledgebase/DSM/tutorial/Storage/How_to_securely_erase_data_on_drive -

Un dashboard Speedtest... c'est complètement inutile... mais ça me donne envie de le mettre en place moi aussi 🤣 Vous avez placer ça dans un dashboard dédié ? Car je trouve que mon dashboard du NAS+Routeur commence à être bien chargé 😅

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Besoin d'aide: Plex ne trouve pas mes films!

MilesTEG1 a répondu à un(e) sujet de Ninom26 dans Plex Media Server

Tu as donc en fait au moins deux soucis différents. Je ne pourrais pas t'aider pour videostation car je ne connais pas, je n'utilise pas. Pour Plex, je vais essayer, mais moi j'utilise la version Docker, pas le paquet fourni dans le centre de paquets. Pour l'accès en extérieur, il faudra s'en occuper une fois que plex fonctionnera en local. 1ère chose à vérifier : est-ce que le parefeu du NAS ne bloquerait pas l'accès au serveur plex ? 2ème chose : Tu pourrais faire des captures d'écrans des réglages de Plex niveau utilisateur du NAS utilisé ? Car je ne sais pas comment ça fonctionne avec le paquet... Est-ce que ton utilisateur sur le NAS a bien les droits de lecture sur les dossiers ? 3ème chose : Est-ce que tes médias sont bien nommés ? (voir les deux liens que j'ai fourni précédemment). Après, je sais pas, on avisera ^^ -

Migration DS214 play vers DS220+

MilesTEG1 a répondu à un(e) sujet de patamel dans Installation, Démarrage et Configuration

@patamel Salut, Si ton 1er disque présent actuellement dans le 214play peut être entièrement effacé, alors procède ainsi : Tu places ce disque dans le 220+ Tu initialises ce disque dans DSM sur le 220+ Tu crées un volume avec ce disque, du coup en basic si tu veux garder le même fonctionnement qu'avec ton 214play. Tu crées les dossiers partagés nécessaires sur le volume1 du 220+. Ensuite, tu copies tes données depuis le 214play sur le volume1 du 220+, en passant par le réseau (partage SMB que tu peux connecter sur le 220+). Une fois les données copiées, et que tu es sûr d'avoir tout copier et donc que le disque encore présent dans le 214play peut être lui aussi totalement effacé, tu pourras le placer dans le 220+ pour l'initialiser (formater) et créer un nouveau volume, puis créer tes dossiers partagés et en faire ce que tu souhaites 😉