-

Compteur de contenus

2944 -

Inscription

-

Dernière visite

-

Jours gagnés

76

Tout ce qui a été posté par MilesTEG1

-

Je te remercie pour ces réponses 😊 Faut-il un abonnement pour avoir le partage des coffre ? Ça m'intéresse pour partager certains mots de passe avec ma femme 😉 Pour l'utilisateur du dossier, j'envisageais de laisser dans le dossier partagé "docker". Ce dernier est-il créé à l'installation du paquet Docker ? Aura-t-il les bons UID/GID ? Car si j'ai bien compris ce que tu as dit, à l'installation du NAS, le compte administrateur que j'aurais créé "Admin-BlaBla" aura un UID de 1026 ? (c'est d'ailleurs le cas, je viens de vérifier avec ceci dans une console SSH : id Admin-BlaBla Sinon, j'ai lu sur cette page ou la précédente que tu (ou un de tes amis) avais utilisé un script de backup. Il sauvegardait quoi ? J'envisage de faire une tâche HyperBackup pour sauvegarder tout le contenu du dossier Docker.

-

Hello 🙂 Maintenant que j'ai un NAS qui peut faire tourner Docker, je vais pouvoir me faire une instance Bitwarden pour voir si ça me convient 🙂 (et remplacer à terme EnPass qui me convient pour le moment). Mon 920+ est encore en phase de badblocks sur un nouveau disque, mais dès que c'est terminé, je vais le configurer pour la production en restaurant/copiant mes données du 214play. Ensuite, ce sera au tour de Bitwarden et Docker. Je vais utiliser un nom de domaine sur mon NAS, et des "sous-domaine" de type service1.nas.ndd.ovh ; service2.nas.ndd.ovh etc... J'aurais aussi donc un certficat Let's Encrypt pour ces domaines, et un proxy inversé qui va faire pointer ces domaines vers le bon service du nas. Du coup, après avoir lu le tuto de ce fil de discussion (et aussi celui de cachem avec bitwardenrs), je pense opter pour le tuto d'installation avec la version officielle, et pas un container préfabriqué. Mais du coup j'ai quelques questions en prévision de son utilisation 🙂 Comme je vais avoir le proxy-inversé, un ndd dédié au service bitwarden et donc le certificat global sur le NAS, dans les questions ci-dessous (pour lesquelles j'ai ajouté une numérotation), devrais-je répondre NON à la question 2 et à la question 5 ? (j'ai aussi lu ce message de ta part en réponse à jfamiens d'où cette interrogation à propose des questions 2 & 5). Ce qui fait que, si j'ai bien tout compris, je pourrais me dispenser de copier/renommer les fichier du certificat : Autre interrogation, vu qu'on se place dans ce dossier : Tout ce qui suit dans le tuto est placé dans ce dossier, rien ne sera placer ailleurs, n'est-ce pas ? Je vais d'ailleurs voir pour créer un petit script de création des dossiers manquants, ça pourra aider ceux qui ont la flemme comme moi de tout créer à la main 😉 Autre interrogation : peut-on limiter les ressources prises par Bitwarden si jamais je constate que ça en prend trop ? (d'ailleurs, c'est plutôt de la RAM ou du CPU que ça va prendre ?) (j'ai 12 Go de ram sur mon 920+, mais je vais avoir au moins 3 carméras de surveillance à gérer 😉) Dernière interrogation, si jamais je dois migrer de NAS, ou que je change le disque, etc... si je sauvegarde le dossier docker (et donc forcément le sous-dossier bitwarden), à la restauration est-ce que j'aurais tout de fonctionnel directement ? Ou faudra-t-il repasser par la configuration depuis 0 du tuto ? Voilà voilà, Merci pour le tuto, et merci d'avance pour les réponses/conseils que vous m'apporterez 😊 Bonne journée

-

Hello, Je venais dire la même chose que ce que vous venez de citer de reolink. Le flux est tout le temps présent. Si la détection de mouvement est activée sur la caméra, en plus du flux il y a les indications de mouvements (je ne sais pas comment elles se présentent, mais je suppose qu'il s'agit de timestamp de début de mouvement et de fin.) Donc que la détection de mouvement soit faite par SS ou par la caméra, SS recevra le flux complet avec les détections de le caméra, mais si SS est configuré pour faire ses propres détections, alors il n'utilisera pas les infos de détection issues de la caméra. Enfin c'est comme ça que j'ai compris le fonctionnement 😉 J'aimerais bien que ce soit SS qui me gère les détections des caméras, mais mon NAS n'est pas assez puissant pour gérer... Faut que je le change 🙂 PS : je suis aussi en ONVIF, mais il semble qu'il y ait moins d'options en ONVIF qu'avec un pilote du DevicePack...

-

Caméra IP PoE Reolink RLC-520 (et 420-5MP)

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Mes caméras sont en ONVIF pour le moment. Peut-être que si j'essayais avec le driver des 420-5MP... edit : Bon bah je n'arrive même plus à ajouter la caméra avec le pilote de Surveillance Station... je ne comprends pas, probablement une question de firmware... Mais en ONVIF ça fonctionne. -

Caméra IP PoE Reolink RLC-520 (et 420-5MP)

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Hello, pour ceux qui ont les Reolink dont je parlais, et que vous avez mis le firmware v3, il est conseillé de revenir sur le dernier en v2 car la version 3 a des petits soucis... je suis revenu à la v2 car j’avais des soucis avec la détection de mouvement et aussi des soucis de flux vidéo qui se coupait... -

Caméra IP PoE Reolink RLC-520 (et 420-5MP)

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Hello, Pour le moment je suis satisfait par les 3 reolink que j'ai (une 420-5MP, et deux 520). Il faut juste savoir qu'elles sont limitées en fonctionnalités par rapport à des caméras plus chers, mais on ne demande pas la même chose à une caméra à 50€ que d'une à 150€. Cependant si je devais en reprendre une, je mettrais un peu plus cher pour avoir plus d'options sur la détection de mouvement. -

Caméra IP PoE Reolink RLC-520 (et 420-5MP)

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Bonsoir, Oui l'audio est aussi enregistré dans Surveillance Station. C'est lié à la configuration de la caméré : il faut que l'audio soit activé. Mais ce n'est qu'en enregistrement. La caméra ne diffuse pas d'audio. Petit lot de MAJ sur les caméras Reolink suivantes : : https://support.reolink.com/hc/en-u [...] PC-51516M- et pour quelques autres : https://support.reolink.com/hc/en-u [...] PC-51516M- Le changelog est limité, mais sur mes RLC-520, je suis passé de ça (datant de début avril) à ça : Bon "Side effect" de la MAJ sur la RLC-420-5MP... Surv. Station ne la reconnait plus Obligé de la passer en ONVIF -

Achat éventuel d'un DS 418 Play

MilesTEG1 a répondu à un(e) question de SynoSyno12 dans Questions avant achat

Bonjour, Le JBOD c'est pas un peu risqué ? Car il me semble que si un disque rend l'âme, tu perds toutes les données, mêmes celles de celui qui fonctionne encore... Sinon pour le NAS, tu fais en sorte d'avoir au moins la même capacité que ce que tu veux sauvegarder, + une marge de sécurité. Exemple : tu as 7 To sur l'ordinateur, prévois au moins 10 To sur le NAS. Tu pourras comme cela ajouter d'autres sauvegardes au besoin ... Pour le prix, tout dépend de ce que tu associes aux données que tu veux sauvegarder. Personnellement je ne mets pas de prix sur mes données importantes, car si je les perds, ça me fera tellement chier... et ce serait une vraie perte... Comme les photos par exemple, ou mes cours... Mais en ce qui concerne d'autres types de données, comme des films/séries de vacances, là je m'en fou... et je n'ai pas d'autre copie ailleurs que sur le NAS qui sert dans ce cas là de serveur de fichier. Après, tu peux bien sur partir sur un boitier USB, mais là tu perds plein d'utilisation possible que tu pourrais avoir avec un NAS. Il faut vraiment que tu définisses très précisément ce que tu veux faire, et ce que tu pourrais avoir envie de faire dans le futur. Car une fois que tu as vu ce que pouvais faire DSM sur le NAS, tu auras envie d'essayer certaines choses, tu y prendras goût, etc... Le NAS peut rester allumer H24 (moyennant un onduleur) et servir dès que le besoin s'en fait sentir. Alors que ton boitier USB, il faut que ton ordinateur soit allumé, que le boitier soit alimenté, branché... Et un PC consomme bien plus qu'un NAS. Pour le serveur KODI/Plex, je ne sais pas quel est ton réel besoin, mais personnellement je n'utilise aucun serveur multimédia, c'est ma TV qui va chercher les fichiers à lire sur le NAS grâce à Kodi qui agit en client ici. Alors oui tu peux utiliser ton PC en guise de serveur de fichiers, mais ce n'est pas une super solution pour moi... qui ait un NAS (je te l'accorde). Je viens de voir que tu avais une vieille TV, donc pas une smartTV je pense. Donc quelque soit le solution que tu adopteras (NAS, HDD-USB) il va te falloir un player pour lire sur la TV. Le moins cher serait probablement de prendre un rPi et d'y mettre une distribution avec KODI. Quoique tu choisisses, planifie bien ton schéma de sauvegarde. Quelles données du PC tu veux sauvegarder (et donc où NAS ou HDD-USB), et à quelle fréquence. Et veux-tu du versionning ? (c'est la gestion des versions). Par exemple, depuis un de mes ordinateurs, j'ai des logiciels qui copie à intervalle de temps régulier (tous les jours, 2 jrs... selon les données). J'ai donc une copie à une date D de mes données. Puis tous les 1 ou 2 jours, mon NAS sauvegarde depuis le volume 1 vers le volume 2 (mes disques sont en basic, pas en RAID SHR) ces données, et en décalé sauvegarde sur un cloud. Comme cela j'ai une copie en local sur le NAS avec versionning pour récupérer les données si le volume principal meurt, et aussi une copie dans le cloud si les deux volumes ou le NAS meurent. Avec un boitier USB, tu ne pourras pas vraiment avoir ça... enfin pas en automatique. Après, c'est ma vision de la sauvegarde, qui n'est pas forcément partagé par tout le monde... J'ai organiser comme ça parce que je n'ai qu'un NAS 2 HDD... Quand j'aurais un 4 baies, il y aura mon volume principal qui sera du SHR sur 2 disques, un 3ème HDD pour surveillance station. et un dernier hdd pour le backup avec versionning du premier volume. Je ne vais pas gagner énormément en capacité de stockage, si ce n'est le nombre de To du disque de surveillance station, mais je n'ai pas un très gros besoin d'espace. J'ai actuellement 2x4To, lorsque j'aurais un 4 baies, je pense que je vais ajouter un 2To purple pour surveillance station, et soit un 4To soit un 8To pour le volume en basic. Voilà voilà 😊 -

Bonjour, Il faut pourtant forcer l'IP en fixe, et supprimer la passerelle par défaut... Voir mettre une passerelle qui ne fonctionne pas. J'ai constaté que sur mes Reolink, supprimer l'IP de la passerelle ne fonctionnait pas, elle revenait systématiquement. Alors que la modifier pour une autre IP fonctionne et reste. Ma vraie passerelle (box) est en 192.168.1.1, j'ai du mettre 192.168.1.254. Il y a aussi deux options à ne surtout pas activer : UPNP et P2P. Mes caméras ne sont pas détectables en dehors du LAN du coup. (et même avant, quand il y avait une passerelle dans leur configuration, ce n'était déjà pas le cas, car je n'ai pas routé les ports dans la box. Mon ReverseProxy sur le NAS route ailleurs le port 80) Vous êtes sous windows ou sous macOS ? (pour vous aider à trouver les menus si vous ne les trouvez pas).

-

Enregistrer sur cloud image Surveillance Station

MilesTEG1 a répondu à un(e) sujet de sebiseba dans Surveillance Station

Bonjour, Actuellement j'utilise 3 caméras reolink avec surveillance station : 2 qui enregistre lorsqu'il y a eu détection de mouvement, et une en continue. J'ai mis le dossier de surveillance station dans CloudSync pour une synchronisation montante seulement sur OneDrive (j'ai un abonnement O365, donc j'ai 1To pour plusieurs comptes). J'ai paramétrer la synchro pour qu'elle se lance toutes les 1h afin d'éviter que ça bouffe trop de CPU (j'ai un vieux 214play... que je vais changer quand le 920+ sortira officiellement) : Ainsi j'ai dans le cloud mes vidéos prises 🙂 Enfin toutes les heures ^^ PS : j'ai aussi des cartes µSD dans les caméras pour stocker un petit peu... -

Achat éventuel d'un DS 418 Play

MilesTEG1 a répondu à un(e) question de SynoSyno12 dans Questions avant achat

Hello, Je vais te faire part de mon expérience avec un DS214play, et de ce que j'envisage pour dans quelques mois. J'ai commencé avec un DS212. Puis j'ai envisagé de le changer. j'ai tout d'abord pensé à un 4 baies, mais le prix était un peu trop élevé à l'époque pour moi, donc je suis resté sur un 2 baies. À ce moment là j'ai du choisir un modèle... J'ai hésité entre le 214play et le 214+, et le 214 tout court. Je m'étais dit que le play serait sympa pour transcoder les vidéos depuis le NAS. Mais j'ai déchanté... car d'une il faut utiliser les applications mobiles pour ça, et ma TV de l'époque n'était pas une smart-TV... Bref, ce n'était pas utilisable pour moi. J'ai trouvé une autre solution. Mais du coup j'ai regretté d'avoir pris un modèle play. et pire, j'ai même regretté d"avoir prix un 2 baies et pas un 4 baies. Donc pour le transcodage, réfléchi bien à ce que tu veux vraiment et à ce que le NAS sera capable de faire et sur quel support/application... Sinon tu risques d'être déçu. Aujourd'hui, j'envisage de changer de NAS, pour plus puissant car mon utilisation a bien évolué. De simple lieu de stockage et de backup, et de synchronisation, j'ai ajouté le serveur VPN, une caméra de surveillance, du reverse proxy, un serveur web, CloudSync (2 comptes OneDrive à synchroniser de manière omnidirectionnel vers le NAS, 1 compte en synchro montante onmidirectionnelle (le dossier de Surveillance Station)), PhotoStation... et bien sur des backup d'un volume à l'autre, des backup d'un volume sur le cloud. Et depuis quelques jours j'ai mis 2 caméras de plus (donc 3 en tout), et là le NAS présente ses limites. (je pense que ça serait aussi arrivé avec un 214+/214 voir un 414...) Tout ça pour dire de prévoir aussi le futur et ses utilisations non prévues. On me conseille ailleurs de partir sur le 920+ qui va sortir dans quelques semaines/mois. Peut-être que toi ce serait le 420+, mais ne lésigne pas, si tu peux te le permettre niveau budget, et même, si par exemple comme moi à l'époque du 214play, économise un mois ou deux de plus pour prendre le modèle du dessus. C'est ce que j'aurais du faire à l'époque. Et ce que je vais faire maintenant, enfin dans quelques mois. Pour tes dernières questions : le NAS se branchera sur le réseau local, et la TV aussi (wifi ou câble, mais souvent les TV sont limitées à 100MB en filaire...) Mais attention au transcodage... je ne maitrise pas le sujet c'est sur, mais je conseillerais plutôt d'utiliser kodi qui va chercher les vidéos sur le NAS en SMB. -

Caméra IP PoE Reolink RLC-520 (et 420-5MP)

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Bonjour, Oui j'ai ce soucis aussi avec la 420. Quand ça passe de la nuit au jour lorsque la lumière automatique que j'ai mise devant la porte de garage s'allume (son capteur IR est un peu trop sensible) à cause d'un chat ou du mouvement du voisin, j'ai une détection de mouvement. Je ne sais pas si c'est aussi le cas avec la lumière du soleil, mais je crois que oui. Pour le pilote, je vais re-tenter le coup pour voir. -

Caméra IP PoE Reolink RLC-520 (et 420-5MP)

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

J'ai bien essayé de mettre le pilotes de la 420, mais ça n'a pas fonctionné... connexion impossible. -

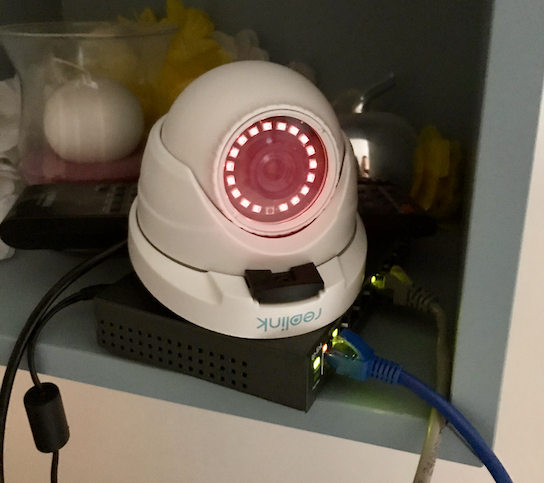

Bonjour, Comme j'ai fait un retour sur un autre forum bien connu (HFR) sur les nouvelles caméra Reolink RLC-520, je me dis que ce serait une bonne idée de vous en faire profiter ici aussi 😉 Il y a quelques mois j'ai fais l’acquisition d'une RLC 420-5MP, et j'ai récemment commandé deux RLC-520 puisque la 420-5MP a été remplacée par la 520. Je prend un petit risque puisque étant toute récente, elle n'a pas de pilote dans Surveillance Station, malgré un DevicePack à jour. Les deux nouvelles caméras vont être montées sur un Junction Box D20 pour y plaquer les connecteurs car mes murs sont épais (mur de façade de maison). J'ai donc reçu mes supports à caméra et mes deux caméras RCL-520 (qui est une 5MP mais n'a plus la mention vu qu'il n'y a que du 5MP), et avant d'installer ça sur le mur, j'ai posé en vrac dans le garage, a proximité du switch TP-Link PoE. Après le setup via l'application Reolink (qui n'est pas compliqué à faire, mais avec leur application c'est quand même pas super optimal, et pour le coup l'application macOS est mieux que la windows car la windows c'est fullscreen obligatoirement... mais passons...) et la MAJ du firmware pour celui sorti il y a quelques semaines, place à la configuration dans Surveillance Station 🙂 Dans les captures ci-dessous, à gauche se trouve la nouvelle caméra RLC-520 et à droite celle acheté fin décembre, la RLC-420-5MP. Aucun pilote n'est disponible pour ce modèle, contrairement à la 420-5MP... Donc la configuration est avec ONVIF (j'ai fait des captures de comparaison pour voir ce qui change entre la caméra avec pilote et celle sans). (Je n'ai jamais essayé la RLC-420 en ONVIF). Le port de connexion n'est du coup pas le même... (je ne sais pas si le port 8000 de la caméra est sécurisé ou pas... mais comme pour l'autre c'est le port 80 (j'ai essayé les autres de la caméra, et seul le 80 fonctionne pour celle avec pilotes). Ensuite, dans les paramètres vidéos, on ne peut pas régler le bitrate sur une valeur constante, c'est forcément variable. Les FPS sont configurables de la même manière sur les deux. [ Sur la partie optimisation : on perd là quelques réglages... Exit l'orientation de la vidéo par Surveillance station, idem pour l'horodatage et la gestion de l'exposition par SV... Pour la détection de mouvement, la sensibilité disparait, mais elle n'était pas modifiable donc, c'est pas une grande perte. Mais il est toujours possible de laisser la détection aux bons soins de Surveillance Station : (perso je laisse la caméra gérer, tant que je n'ai pas mis en situation les caméras). Voilà voilà. Quelques réglages perdu pour la caméra sans pilote donc en ONVIF. Personnellement, ça ne me gène pas car je n'utilisais pas ces réglages pour l'autre, laissant la caméra gérer elle-même avec ses paramètres. Le client mobile de Reolink est pas trop mal. Maintenant reste à voir comment le NAS va subir cet ajout de 2 caméras à l'existante 😄 j'espère qu'il ne va pas trop ramer... Voilà voilà 🙂 Je ferais quelques photos des caméras quand je les installerai mercredi (je vais chercher du câble réseau chez Leroymerlin ce mercredi). Le modèle 520 est un peu plus petit que le 420-5MP. Une partie est en plastique donc le support de fixation, et c'est selon moi le seul gros défaut de ce modèle... Bon mes caméras vont être à presque 3m de hauteur... ++ Miles

-

Ok merci pour cette confirmation 😉 (j'ai édité mon message en disant la même chose ^^ : tu confirmes donc que ce n'est pas un défaut ^^ ouf merci 😃)

-

Bon, je pense que c'est le détecteur de mouvement ou le capteur de lumière qui permet de décider quand passer en mode nuit ou jour... Car dans la description du produit il est marqué : Je compte bien 18 LED IR + celle qui n'est pas allumée, donc toutes fonctionnent bien.

-

@Antimousse : dit, est-ce que tu pourrais me dire si c'est normal qu'une des diodes IR ne semble pas être active ? C'est le capteur de mouvement ou bien une diode IR morte ? Car si c'est le dernier cas, je fais une demande d'échange à Amazon.

-

je n’ai pas activé l’Ipv6 dans ma Livebox... donc je n’ai pas d’ipv6. Tant que je n’ai pas un besoin impératif de l’activer je le laisse désactivé 😜

-

J’ai effectivement changé le mot de passe du compte admin de la caméra 😉 L’option UPNP est bien désactivée et j’ai même aussi désactivé l’option p2p dont je ne vois pas trop l’intérêt. donc du coup ma caméra est protégée si je comprends bien 😁 Nickel 👌🏻 merci

-

Bonjour, Je débute dans l'utilisation de Surveillance Station avec une caméra Reolink RLC-420-5MP. Comment as-tu "tout fermé" ? Ça m'inquiète depuis que j'ai branché la caméra, est-ce que son flux vidéo est visible depuis le net sans mot de passe ? J'ai mis un mot de passe à l'utilisateur admin, mais je n'ai routé aucun port de la caméra avec ma Livebox. J'espère que ça suffira 😉 J'accède à Surveillacne Station en local, mais aussi via internet grace à mon ndd (qui est sécurisé avec le tuto de fenrir mis à ma sauce). Pas d'attaque sur DMS donc. Pour accéder à la caméra avec l'application officielle, je dois soit être connecté en wifi, soit accéder au nas via le serveur vpn de ce dernier avec ma 4G. Penses-tu que celà est suffisant pour protéger l'accès à la caméra ? Si un jour (et je pense que ça arrivera forcément) je dois passer par l'IPV6, vais-je rencontrer des soucis ? Edit : Pour accéder à surveillance station, j'utilise mon utilisateur admin (ce n'est pas ce nom car le compte "admin" est désactivé ^^), j'ai pu voir qu'un utilisateur normal n'avait pas accès aux paramètres de la caméra, j'ai donc passé un de ces utilisateurs comme Gestionnaire via la mini-app "Utilisateurs"' de SurvStation. Mais au final je n'utilise pas ce login utilisateur... Merci d'avance 🙂

-

Ha je me doutais pour le SAV avec la chine 😮 Je ne commanderais que le boitier chez eux 😉 la caméra c'est chez amazon que je l'ai commandé, avec -25% d'ailleurs, j'ai été surpris de la réduction au moment de valider le panier. Sinon, il me faut un foret d'au moins 46 cm de longueur... et là j'ai regardé les prix, ça pique un peu 🤣 Je vais faire avec le diamètre 16 que j'ai déjà 😉 et je vais d'ailleurs m'en servir pour fixer une applique à détecteur de mouvement : Ça fera de la lumière quand quelqu'un arrivera vers la porte ^^

-

Merci, j'imaginais un bricolage pareil 🙂 Je n'ai pas de si gros foret SDS pour mon perfo, mais j'ai un 16mm, qui ne suffira pas... Par contre, en prenant le boitier optionnel Junction Box D20 ce sera nickel, je pourrais caser les gros embouts sans devoir faire un très gros trou 🙂 je n'aurais qu'à passer le câble RJ45, et le sertir coté caméra ^^ Tu les as commandé où tes caméras ? je voulais en prendre une sur amazon pour vérifier que j'arrive à la faire fonctionner avec mon 214play. Et si tout va bien, je commande chez le fabriquant pour avoir le support.

-

Hello, Antimousse, j'aurais une question quand à l'installation (montage) des reolink. Je compte fixer la caméra sur un mur extérieur, il est en parpaing, donc épais. J'ai pu voir que le câble d'alimentation était assez gros et avec 3 embouts (RJ45, un d'alim externer, et un autre)... Vous avez fait quoi comme trou pour passer tout ça ? Car là ça m'inquiète sur le diamètre du foret à utiliser... et du coup ça va faire un sacré gros trou dans mon mur... alors bon c'est entre le garage et l'extérieur, mais quand même... Ça existe des caméra avec un câble de connexion beaucoup plus fin, ou démontable au niveau de la caméra pour le passer plus facilement ? Ou bien une caméra qui n'aurait qu'une prise rj45 (sans câble donc) en pour la raccorder en poe ? Merci d'avance

-

Besoin de conseils sur une caméra IP PoE extérieure compatible Surveillance Station

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Peut-être pas sur une caméra compatible avec le syno, mais par exemple sur la Netatmo Presence il y a une lampe. Bon après la solution que tu donnes me semble le meilleur des deux mondes 😉 Faut juste que je trouve un projecteur de lumière avec détecteur de mouvement ;). Sinon, d'autres conseils de caméra ? Rappels des critères (MAJ) : compatible avec synology (pour Surveillance station) vision nocturne IR HP / Micro (avec éventuellement une alarme) PoE -

Besoin de conseils sur une caméra IP PoE extérieure compatible Surveillance Station

MilesTEG1 a répondu à un(e) sujet de MilesTEG1 dans Surveillance Station

Hello, merci pour ta réponse. Alors, ce que j'entends par lumière, c'est de la lumière blanche pour éclairer quand un mouvement est détecté. Un spot quoi 🙂 En plus de la vision IR. Après c'est probablement redondant, mais ça me servirait quand je rentre chez moi pour avoir de la lumière ^^ Sinon pour l'audio, je veux aussi un HP qui diffuse du son genre je gueule sur l’intrus ou donne une consigne à un livreur par exemple. Donc il faut micro et haut-parleur. La Reolink ne semble pas avoir de haut-parleur, juste un micro pour enregistrer. non ? En tout cas merci pour le conseil ^^