Diplo95

Membres-

Compteur de contenus

147 -

Inscription

-

Dernière visite

À propos de Diplo95

.png.96b3b3865e7602c8e02642dcb636f80b.png)

Mon Profil

-

Mon NAS

DS213J DS220+ avec 2 x WESTERN DIGITAL WD Red Plus 6 To SATA 6Gb/s WD60EFRX

Visiteurs récents du profil

2749 visualisations du profil

Diplo95's Achievements

-

Bonjour, Je suis d'accord avec toi, mais mon problème se situe lors de la sauvegarde. Je vais essayer de creuser le sujet, mais reste à l'écoute si qqn a une solution avant que je trouve.

-

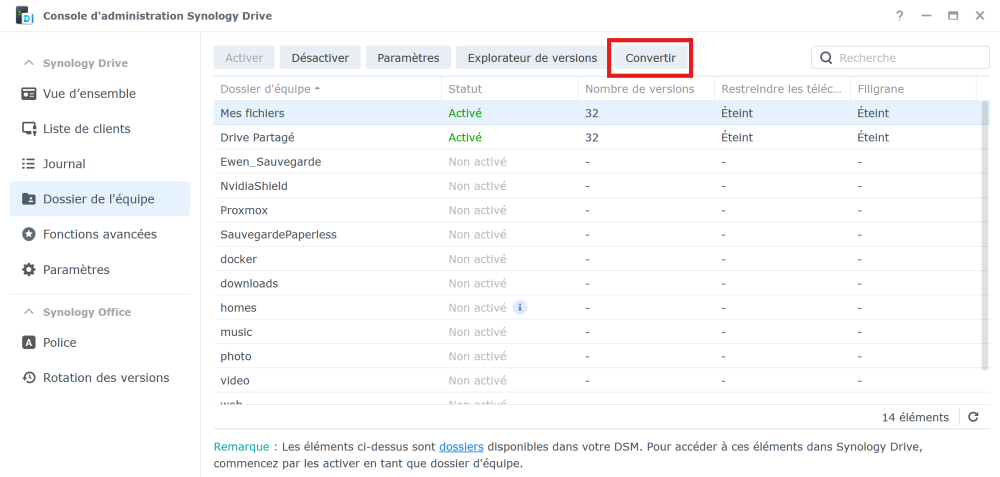

Bonjour, il y a eu un changement : https://kb.synology.com/fr-fr/DSM/tutorial/Convert_My_Drive_into_home_folder_in_Synology_Drive Avant la conversion, le Drive synchronisait le contenu du dossier /home/drive Ensuite, le Drive synchronise le dossier /home (Enfin, c'est comme ça que je le comprends). Mais, dans /home il y a aussi le dossier /home/photos qui contient les photos perso. Et c'est là qu'apparait mon problème : lorsque j'ai voulu mettre en place ma stratégie de backUp vers un NAS distant, je me suis aperçu que la sauvegarde de l'application Drive sauvegardait également les photos persos, MAIS que la sauvegarde de l'application Photos le faisait aussi (enfin, là je suis plus sur une supposition car je n'ai pas trouvé le journal détaillé de sauvegarde). Du coup, on a sauvegardé deux fois la même donnée. Et ça peut représenter pas mal d'espace occupé. J'espère que je me fais bien comprendre.

-

Bonjour, il me semblait que Drive ne prenait la totalité du dossier "home" que si on "convertissait" le dossier de l'équipe : Est ce correct ? Alors ça m'intéresse : comment définit-on un dossier particulier pour son Drive ? Je n'arrive pas à trouver.

-

Bonjour à tous, je me retrouve dans une situation que je n'arrive pas à résoudre. J'ai un DS224+ avec DSM 7.2.2 J'utilise Drive et Photos. J'ai essayé de mettre en place des backup vers un autre NAS. En paramétrant la sauvegarde de l'application Drive, je me suis aperçu d'une bizarrerie. En effet, il n'y a pas grand-chose dans les dossiers Drive des différents utilisateurs. Or, lorsque j'ai fait un test, je voyais des Gb et des Gb de données qui partaient ! En cherchant, j'ai constaté que j'avais des logiques différentes selon les utilisateurs : - un premier utilisateur a un dossier home, dans lequel il y a un dossier photo et un dossier SynologyDrive. Ainsi, quand je sauvegarde l'application photo, ça sauvegarde les photos, qu'il y a dans /photos, et quand je sauvegarde l'application Drive, ça sauvegarde le dossier /SynologyDrive. - Pour un deuxième utilisateur, il y a le dossier /home, bien sûr, un dossier /home/photos, mais pas de dossier /home/SynologyDrive. Ainsi, il considère que le Drive est le dossier /home dans sa globalité. Problème : lorsque je fais la sauvegarde de l'application Drive, ça sauvegarde les documents contenus dans le drive, mais aussi les photos ! Ainsi, ces photos sont sauvegardées deux fois : lors de la sauvegarde de Drive et lors de la sauvegarde de Photos ! J'ai lu qu'il y avait une option dans les paramètres du Drive pour "convertir" qq chose (je n'ai pas vraiment compris les implications) et que cette conversion était définitive. Qu'à l'issue de cette conversion, il n'y avait pas de retour arrière possible, et que l'effet était justement de considérer le /home comme le dossier Drive. Or, ce que je ne comprends pas, c'est que tous les utilisateurs n'ont pas la même logique. Ça m'embête vraiment de sauvegarder ces photos deux fois. Comment faire pour différencier les dossiers de Photos et de Drive ?

-

DS220+, freebox Ultra et aggregation

Diplo95 a répondu à un(e) sujet de Diplo95 dans Internet et réseaux

Merci à tous pour vos réponses qui m'ont éclairé. Effectivement, le jeu n'en vaut sûrement pas la chandelle. Je vais quand même en profiter pour faire ces tests de vitesse en lecture/écriture pour regarder la réalité des choses : je n'avais pas encore ce savoir. Et merci @church, je pense que je vais commencer par ça : un petit switch qui augmentera ma bande passante. -

DS220+, freebox Ultra et aggregation

Diplo95 a répondu à un(e) sujet de Diplo95 dans Internet et réseaux

Dans l'absolu, c'est le challenge de mettre en place un truc que je ne connais pas qui me pousse. Je le prends comme une nouvelle étape dans mon apprentissage. C'est ça, ce qui fait deux fois le débit actuel. Une augmentation non négligeable dans l'absolu. Quand tu dis que l'agrégation n'apporte pas grand-chose, que veux-tu dire ? Que ce n'est pas vraiment un x2 comme je me l'étais imaginé ? En tout cas, merci pour vos réponses. -

Bonjour à tous, je suis à la recherche d'infos sur l'aggregation pour mon DS220+. En effet, je viens de changer de box pour la Freebox Ultra. J'ai donc un débit dont je ne peux pas profiter à ce jour avec mon NAS. En effet, il est connecté directement en RJ45 à ma box, je suis donc limité par le port Gigabit sur lequel il est connecté. Je précise que je souhaite améliorer la connexion entre mon NAS et internet, et non pas entre mon NAS et mon réseau domestique (j'ai lu que ce n'était pas possible sur ce sujet). Du coup, pour profiter du port SFP 10G de la freebox, j'avais pensé acheter un switch avec des ports SFP+ et, de ce switch faire de l'agrégation vers le NAS DS220+. Est-ce que vous pensez que mon raisonnement est cohérent ? Est-ce que quelqu'un a un retour d'expérience de ce style de branchement ? J'ai commencé à chercher le matériel nécessaire, mais les switchs de grande marque sont hors de prix. J'ai trouvé des switchs abordables sur un site de vente en ligne très connu, mais j'ai quand même des doutes sur le matériel : ce switch YuLinca, me donne l'impression que mes données vont aller directement en Chine. (remarquez, si je prends du Netgear, peut-être que ça va directement aux States !) Bref, je suis preneur de tout retour d'expérience.

-

Bonjour, j'ai moi aussi installé stirling récemment (aujourd'hui en fait 🙂 ) Je n'ai pas eu trop de soucis. J'étais parti du même tuto que toi @PascalFr, pour finalement utiliser le fichier docker-compose.yml que l'on trouve sur le github du projet. J'ai utilisé la version complète. Dans le message que tu as publié, je vois qu'il y a déjà des problèmes : en particulier des messages d'erreur qui arrivent assez vite : Trying to download from: https://github.com/Stirling-Tools/Stirling-PDF/releases/download/v0.22.0/Stirling-PDF-with-login.jar /scripts/init.sh: line 19: usermod: command not found id: unknown user stirlingpdfgroup /scripts/init.sh: line 23: groupmod: command not found Il faut peut-être chercher par ici. Pourrais-tu poster ton fichier docker-compose ?

-

Bonjour @.Shad., merci de te pencher sur mon problème. APP_PORT : je prends ta remarque, mais j'avoue que je trouve Docker très pratique, mais que je n'ai encore tout compris des rouages du fonctionnement. Donc Joplin fonctionnant parfaitement, pour l'instant je ne creuse pas plus loin, je ne suis pas assez calé en réseau pour être sûr de ne pas répondre une bêtise, j'essaie quand même : je pensais rendre joignable gotify par l'intermédiaire de mon proxy inverse. J'imagine alors que n'importe quelle appli qui souhaite ensuite push des notifications fera appel à ce service par une requête qui passera par le wan. Si c'est le cas, effectivement, ça peut être plus intéressant de ne pas faire sortir ces messages de mon réseau local. J'ai cependant résolu mon problème. Il était dû à ces warnings concernant les containers orphelins. J'ai fait une rapide recherche et découvert que docker compose utilise le nom du dossier dans lequel le docker-compose.yml est situé ici. Ainsi, si on met tous ses docker-compose.yml dans des dossiers qui portent le même nom, docker-compose trouve alors différents projets qui portent le même nom. J'ai résolu en utilisant cette méthode : https://stackoverflow.com/questions/50947938/docker-compose-orphan-containers-warning Dans mon dossier script, j'ai crée un fichier .env dans lequel j'ai inséré une variable d'environnement : COMPOSE_PROJECT_NAME=myproject Et j'ai maintenant un container qui se construit sans intérférer avec le container joplin et une appli qui tourne. Ne me reste plus qu'à me pencher sur la config réseau de mon appli.

-

Bonjour j'ai un serveur joplin qui fonctionne parfaitement depuis des mois. J'essaie aujoud'hui de monter un serveur de notifications gotify en docker. Mais il semble qu'il y ait un conflit entre les deux, sans que j'arrive à comprendre où. Voici le docker-compose de joplin : version: '3' services: db: image: postgres:13.1 # Download latest postgres image container_name: postgres-db # Here you can give the container a name of your liking restart: unless-stopped # Restart if not stopped manually volumes: - /volume1/docker/joplin/joplin-data:/var/lib/postgresql/data # Make database files persistent. Otherwise your data is lost when the container is destroyed. environment: - APP_PORT=22300 # Specify port joplin-server is reachable at - POSTGRES_PASSWORD=****** # Specify database password - POSTGRES_USER=****** # Specify database user - POSTGRES_DB=joplin # Specify database name app: image: joplin/server:latest # Download joplin-server image 2.2.5 the latest at the time container_name: joplin-server labels: - com.centurylinklabs.watchtower.enable=true depends_on: - db ports: - "22300:22300" # Expose internal port to LAN restart: unless-stopped environment: - APP_BASE_URL=https://joplin.**********.fr # If you do not want to expose joplin-server to the internet use your LAN-IP and port - DB_CLIENT=pg - POSTGRES_PASSWORD=****** # Must be the same as above - POSTGRES_DATABASE=joplin # Must be the same as above - POSTGRES_USER=******* # Must be the same as above - POSTGRES_PORT=5432 # Postgres internal port - POSTGRES_HOST=db Voici le docker-compose du serveur gotify : version: "3" services: app: image: gotify/server container_name: gotify restart: unless-stopped ports: - 127.0.0.1:8764:80 environment: - TZ='Europe/Paris' - GOTIFY_DEFAULTUSER_NAME=admin - GOTIFY_DEFAULTUSER_PASS=admin - GOTIFY_PASSSTRENGTH=10 - GOTIFY_UPLOADEDIMAGESDIR=data/images - GOTIFY_PLUGINSDIR=data/plugins volumes: - ./data:/app/data Lorsque j'essaie de monter le conteneur gotify, voici le retour en ligne de commandes : root@DS220:/volume1/docker/gotify/script# docker-compose up -d [+] Running 5/5 ⠿ app Pulled 9.3s ⠿ 00d3338ddf14 Pull complete 3.5s ⠿ 557ea8465e9a Pull complete 4.6s ⠿ 3ecb6f16884e Pull complete 5.5s ⠿ 793754435704 Pull complete 6.6s WARN[0009] Found orphan containers ([sabnzbd sonarr radarr jellyfin postgres-db watchtower]) for this project. If you removed or renamed this service in your compose file, you can run this command with the --remove-orphans flag to clean it up. [+] Running 1/2 ⠿ Container joplin-server Recreated 39.9s ⠼ Container gotify Starting 6.4s Error response from daemon: driver failed programming external connectivity on endpoint gotify (a9b441ca577a1716274272aca0f4d30b8df97e992610938065568ad31b04d1fa): Error starting userland proxy: listen tcp4 127.0.0.1:8000: bind: address already in use root@DS220:/volume1/docker/gotify/script# Et donc je constate qu'il me recrée l'image joplin, et je ne sais pas pourquoi. Plus problématique : en fait, il le recrée, mais ça plante : je ne peux plus synchroniser avec les clients joplin. J'ai pensé à un problème de ports, alors j'ai cherché des conflits : root@DS220:/volume1/docker/gotify/script# netstat -tulpn | grep LISTEN tcp 0 0 0.0.0.0:662 0.0.0.0:* LISTEN 10076/statd tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 9150/sshd: /usr/bin tcp 0 0 127.0.0.1:33304 0.0.0.0:* LISTEN 2004/synomibactiono tcp 0 0 127.0.0.1:5432 0.0.0.0:* LISTEN 20407/postgres tcp 0 0 0.0.0.0:443 0.0.0.0:* LISTEN 15980/nginx: master tcp 0 0 0.0.0.0:892 0.0.0.0:* LISTEN 10052/mountd tcp 0 0 0.0.0.0:8989 0.0.0.0:* LISTEN 501/docker-proxy tcp 0 0 0.0.0.0:445 0.0.0.0:* LISTEN 13522/smbd tcp 0 0 0.0.0.0:8096 0.0.0.0:* LISTEN 419/jellyfin tcp 0 0 127.0.0.1:512 0.0.0.0:* LISTEN 29315/termd tcp 0 0 0.0.0.0:8000 0.0.0.0:* LISTEN 29198/docker-proxy tcp 0 0 0.0.0.0:2049 0.0.0.0:* LISTEN - tcp 0 0 127.0.0.1:161 0.0.0.0:* LISTEN 10516/snmpd tcp 0 0 0.0.0.0:9090 0.0.0.0:* LISTEN 3325/docker-proxy tcp 0 0 0.0.0.0:6690 0.0.0.0:* LISTEN 5194/syncd tcp 0 0 0.0.0.0:9091 0.0.0.0:* LISTEN 18872/transmission- tcp 0 0 0.0.0.0:10211 0.0.0.0:* LISTEN 26005/docker-proxy tcp 0 0 0.0.0.0:10212 0.0.0.0:* LISTEN 25963/docker-proxy tcp 0 0 0.0.0.0:7878 0.0.0.0:* LISTEN 32194/docker-proxy tcp 0 0 0.0.0.0:9000 0.0.0.0:* LISTEN 29171/docker-proxy tcp 0 0 0.0.0.0:5000 0.0.0.0:* LISTEN 15980/nginx: master tcp 0 0 0.0.0.0:5001 0.0.0.0:* LISTEN 15980/nginx: master tcp 0 0 0.0.0.0:139 0.0.0.0:* LISTEN 13522/smbd tcp 0 0 0.0.0.0:5357 0.0.0.0:* LISTEN 15980/nginx: master tcp 0 0 0.0.0.0:4045 0.0.0.0:* LISTEN - tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 7439/rpcbind tcp 0 0 0.0.0.0:8080 0.0.0.0:* LISTEN 3351/docker-proxy tcp 0 0 0.0.0.0:80 0.0.0.0:* LISTEN 15980/nginx: master tcp 0 0 0.0.0.0:10002 0.0.0.0:* LISTEN 15980/nginx: master tcp 0 0 127.0.0.1:915 0.0.0.0:* LISTEN 23389/httpd24 tcp 0 0 0.0.0.0:51413 0.0.0.0:* LISTEN 18872/transmission- tcp6 0 0 :::662 :::* LISTEN 10076/statd tcp6 0 0 :::22 :::* LISTEN 9150/sshd: /usr/bin tcp6 0 0 :::3001 :::* LISTEN 23745/AdGuardHome tcp6 0 0 :::443 :::* LISTEN 15980/nginx: master tcp6 0 0 :::892 :::* LISTEN 10052/mountd tcp6 0 0 :::8989 :::* LISTEN 506/docker-proxy tcp6 0 0 :::3261 :::* LISTEN - tcp6 0 0 :::445 :::* LISTEN 13522/smbd tcp6 0 0 :::3263 :::* LISTEN - tcp6 0 0 :::8000 :::* LISTEN 29203/docker-proxy tcp6 0 0 :::3264 :::* LISTEN - tcp6 0 0 :::3265 :::* LISTEN 5859/scsi_plugin_se tcp6 0 0 :::2049 :::* LISTEN - tcp6 0 0 :::9090 :::* LISTEN 3331/docker-proxy tcp6 0 0 :::6690 :::* LISTEN 5194/syncd tcp6 0 0 :::10211 :::* LISTEN 26020/docker-proxy tcp6 0 0 :::10212 :::* LISTEN 25969/docker-proxy tcp6 0 0 :::7878 :::* LISTEN 32200/docker-proxy tcp6 0 0 :::9000 :::* LISTEN 29177/docker-proxy tcp6 0 0 :::5000 :::* LISTEN 15980/nginx: master tcp6 0 0 :::5001 :::* LISTEN 15980/nginx: master tcp6 0 0 :::139 :::* LISTEN 13522/smbd tcp6 0 0 :::5005 :::* LISTEN 17507/httpd tcp6 0 0 :::5357 :::* LISTEN 15980/nginx: master tcp6 0 0 :::4045 :::* LISTEN - tcp6 0 0 :::5006 :::* LISTEN 17507/httpd tcp6 0 0 :::111 :::* LISTEN 7439/rpcbind tcp6 0 0 :::8080 :::* LISTEN 3360/docker-proxy tcp6 0 0 :::80 :::* LISTEN 15980/nginx: master tcp6 0 0 :::10002 :::* LISTEN 15980/nginx: master tcp6 0 0 :::51413 :::* LISTEN 18872/transmission- tcp6 0 0 :::53 :::* LISTEN 23745/AdGuardHome root@DS220:/volume1/docker/gotify/script# Mais il n'y a rien qui me saute aux yeux. Une petite idée ? Merci

-

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

Diplo95 a répondu à un(e) sujet de Einsteinium dans Tutoriels

@Einsteinium, @oracle7 Bonjour, pour mon cas personnel, en changeant dans le fichier account.conf les variables SAVED_SYNO_Username et SAVED_SYNO_Password en respectivement SYNO_Username et SYNO_Password, je n'ai plus aucun message d'erreur, le déploiement se fait à nouveau. En toute humilité, je pense comme @Eridani78 qu'il faudrait modifier le tuto. -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

Diplo95 a répondu à un(e) sujet de Einsteinium dans Tutoriels

@oracle7 Je comprends toutes les remarques que tu me fais et elles sont toutes cohérentes. MAIS : tout fonctionnait à merveille depuis des mois avec la configuration que j'avais. Je sais que ce n'est pas un argument recevable lorsque soudainement ça bugge, et c'est donc l'occasion de repartir sur des bases plus saines. 1. Je suis d'accord avec tes remarques. Cependant, je ne me rappelle plus pourquoi j'avais dû adapter le fichier account.conf à l'époque. J'ai changé les ports d'accès à mon NAS en suivant les très bons tutos trouvés sur ce forum. Je pense que tu as raison pour le port 443 : c'est l'unique port d'entrée à mon NAS, mais depuis l'extérieur uniquement, grâce à l'utilisation du reverse proxy. Je vais revoir cet aspect. 2. Je vais donc essayer en enlevant tous les caractères spéciaux. Mais encore une fois, tout fonctionnait bien jusqu'à il y a quelques jours. Est-ce que ça ne baisse pas le niveau de protection du mot de passe ? 3. J'ai bien lu le tuto, et plusieurs fois. Je ne comprends toujours pas l'utilité du docker-compose.yml. En effet, n'est-ce pas la tache planifiée quotidienne qui crée le docker ? -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

Diplo95 a répondu à un(e) sujet de Einsteinium dans Tutoriels

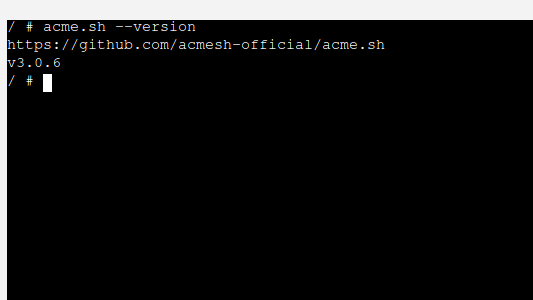

Merci @oracle7 de te pencher sur mon problème. J'aurais dû rentrer en peu plus dans les détails : 1. Pour le AUTOUPGRADE : Je ne savais pas. Cependant, après avoir défini la tâche paramétrable comme ceci : docker pull neilpang/acme.sh:3.0.5 docker stop Acme docker rm Acme docker image prune -f docker volume ls -qf dangling=true | xargs -r docker volume rm docker run -d --cpu-shares=10 --memory=134217728 --name=Acme -v /volume1/docker/Acme:/acme.sh:rw --restart always neilpang/acme.sh:latest daemon et changé account.conf comme ceci : LOG_FILE="/acme.sh/acme.sh.log" LOG_LEVEL=1 AUTO_UPGRADE='0' #NO_TIMESTAMP=1 USER_PATH='/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin' SAVED_OVH_AK='**************' SAVED_OVH_AS='*************************' SAVED_OVH_CK='**************************' DEFAULT_ACME_SERVER='https://acme-v02.api.letsencrypt.org/directory' SAVED_SYNO_Scheme='http' SAVED_SYNO_Hostname='192.168.*.*' SAVED_SYNO_Port='443' SAVED_SYNO_Username='*******************' SAVED_SYNO_Password='*********************' SAVED_SYNO_DID='' SAVED_SYNO_Certificate='ACME_Wilcard_LE_*.*************.fr' UPGRADE_HASH='***************************************' lorsque je lance manuellement la tache, je m'attends donc à avoir la version 3.0.5 du script acme.sh. Or : 2. J'ai lu comme toi le message d'erreur et j'ai bien vérifié les variables du fichier account.conf -> elles sont correctes et ne créaient pas d'erreur jusque là. J'ai un doute sur un caractère que j'ai utilisé dans mon MDP : '&' . En effet, dans mon message d'erreur, il recopie le mot de passe après ce caractère. Peut être est un caractère qui induit une particularité, y compris entre ' '. 3. J'aurais dû être beaucoup plus précis en effet. Je trouve bien le fichier docker-compose en première page du post (d'ailleurs comment sais tu que je porte effectivement des lunettes 🙂 ). Je ne le retrouve par contre dans aucun de mes dossiers sur le NAS. -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

Diplo95 a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour à tous, j'ai un soucis lors du renouvellement de mon certificat depuis quelques jours. J'ai lu les commentaires récents et je l'attribue donc éventuellement au déploiement de la version 3.0.6 du script Acme. Tout d'abord, voici mon message d'erreur : Le planificateur de tâches a terminé une tâche planifiée. Tâche : RenewCertifLE_Docker Heure de début : Sun, 05 Feb 2023 05:00:01 GMT Heure d'arrêt : Sun, 05 Feb 2023 05:00:02 GMT État actuel : 1 (Interrompu) Sortie/erreur standard : /usr/local/bin/acme.sh: eval: line 2401: **************: not found [Sun Feb 5 04:00:02 UTC 2023] SYNO_Username & SYNO_Password must be set [Sun Feb 5 04:00:02 UTC 2023] Error deploy for domain:gpointeau.fr [Sun Feb 5 04:00:02 UTC 2023] Deploy error. Il se trouve que les ************* correspondent à une partie de mon mot de passe pour accéder au compte créé exclusivement pour le renouvellement de mon certificat Let's Encrypt. Je rajoute que ce renouvellement se passait sans aucun soucis jusqu'à maintenant. Pour faire un test, je souhaite donc revenir à la version 3.0.5 du script Acme. C'est là que mes lacunes apparaissent. J'ai suivi le tuto de la première page, mais je ne trouve plus le fichier docker-compose.yml en Cbis. Je pense donc que j'ai dû faire uniquement la partie C. J'ai donc modifié la tache récurrente en : docker pull neilpang/acme.sh:3.0.5 docker stop Acme docker rm Acme docker image prune -f docker volume ls -qf dangling=true | xargs -r docker volume rm docker run -d --cpu-shares=10 --memory=134217728 --name=Acme -v /volume1/docker/Acme:/acme.sh:rw --restart always J'ai lancé manuellement cette tâche, mais la version du script reste toujours la même : 3.0.6. Pouvez-vous m'expliquer comment revenir à la version 3.0.5 svp ? Merci -

[Résolu] Plus d'accès NFS après mise à jour du DSM

Diplo95 a répondu à un(e) sujet de 17795 dans Installation, Démarrage et Configuration

Bonjour @.Shad. si je suis ta procédure, le dossier se monte correctement. Le problème est dans le montage automatique au démarrage.