-

Compteur de contenus

6673 -

Inscription

-

Dernière visite

-

Jours gagnés

154

Tout ce qui a été posté par .Shad.

-

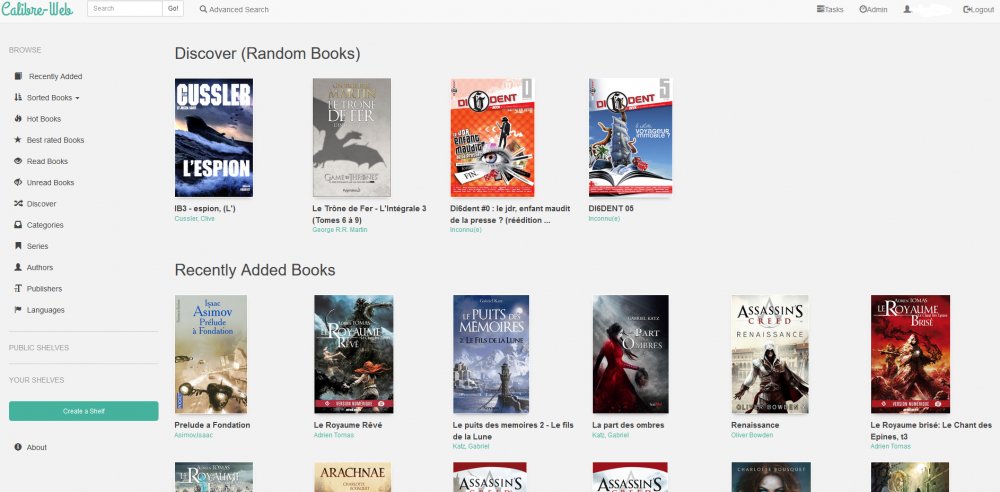

Calibre peut tout à fait stocker sa BDD sur le NAS, et tu peux utiliser Calibre-web via Docker pour la rendre accessible, lisible en ligne, téléchargeable, et le reste...

-

Justement ce que tu veux faire, grâce aux vues. L'intérêt c'est qu'en local (et en VPN par exemple), quand tu tapes toto.synology.me ça t'amène à : 192.168.X.X De l'extérieur, ça pointera sur ton IP publique. C'est exactement ce que permettent de faire les vues combinées aux zones d'un serveur DNS. Voir le tutoriel en question pour la mise en œuvre. Pour le reste, un proxy inversé en quelques mots : C'est un frontend, qui va permettre de rediriger, suivant des critères définis en amont, un nom de domaine vers un service en particulier, le backend. Généralement c'est le nom de domaine demandé qui va permettre d'orienter la demande vers le périphérique concerné. Il est tout à fait possible de créer des sous-domaines de l'adresse fournie par Synology, en revanche je ne pourrais pas te dire pour DuckDNS, je n'ai jamais utilisé. OVH ou d'autres te proposent en revanche une maîtrise totale de ton nom de domaine, et c'est parfois moins d'1€/an... Donc tu peux tout à fait définir un sous-domaine, disons que https://domoticz.duckdns.truc renvoie vers http://IP_DOMOTICZ:PORT. Et le gros avantage du proxy inversé, c'est que tu peux très bien appliquer le certificat LE au niveau du proxy, et donc aucun besoin de le gérer au niveau de l'application, comme tu le fais maintenant. Je t'invite à lire le tutoriel de la mise en place du paquet DNS serveur et du proxy inversé, ce sont les exactes réponses à tes questions.

-

Lancer le serveur Calibre depuis le NAS

.Shad. a répondu à un(e) sujet de techaddict dans Installation, Démarrage et Configuration

Salut, Je pense que tu devrais consulter les autres sujets du forum, car cela n'a pas grand chose à voir avec ta question initiale sur Calibre. -

C'est où qu'on signe ?? 😛 Bienvenue !

-

Ce serait en effet pas mal d'avancer là-dessus, car quand on passe 95% de son temps à commenter les sujets ce n'est pas un problème, c'est beaucoup plus délicat par moment de trouver la section appropriée quand on veut par contre initier une demande. 😛 Si besoin je peux aider.

-

Ah le délai est assez court, au regard du prix assez dérisoire du stockage, c'est une solution intéressante. Même si je chiffre mes sauvegardes, j'avoue hésiter à confier mes données à des entreprises qui ne sont pas soumises à la RPGD (j'utilise C2 de Synology qui est sous législation allemande).

-

Salut, On apprécie que les nouveaux membres se présentent avant de poster, il y a une section du forum qui y est dédiée. Pour tes questions, plusieurs choses m'interpellent : Là tu es en train de dire que tu arrives à te connecter à ton VPN depuis le réseau local ? Ce n'est pas l'extérieur et ça n'a pas d'intérêt pour une utilisation classique. Tu peux toujours configurer le DDNS Synology dans Panneau de configuration -> Accès externe, même si dans ton cas, avec une IP fixe, tu as plus intérêt à utiliser le paquet DNS Serveur de Synology. Tu peux très bien exposer les services de ton Synology vers l'extérieur, même si de manière générale il faut essayer d'éviter. Moi dans mon cas je rends accessible via navigateur et applications android tout ce qui touche au Multimedia, je réserve l'utilisation de Filestation et DSM au réseau local/VPN seulement. C'est vraiment une question d'utilisation personnelle. Typiquement au boulot je ne peux pas installer de VPN sur les PC, donc je suis obligé d'exposer mes services via SSL si je veux pouvoir y accéder. La solution à ton problème s'appelle un proxy inversé (reverse proxy). On a un tutoriel qui y est dédié :

-

Ca dépend comment tu configures ta sauvegarde HyperBackup, il faut inclure du coup tous les dossiers partagés et tous les paquets que tu utilises. Une sauvegarde HyperBackup comprend aussi la configuration du système (DSM). Par prudence, j'ai toujours une sauvegarde de la configuration à part, car c'est ce que je trouve le plus long à refaire, et c'est le plus léger à sauvegarder. Par contre, de ce que j'avais lu, je crois que les données stockées sur Glacier ne sont pas dans une logique de disponibilité immédiate non ? Si c'est pour une utilisation personnelle j'imagine que ce n'est pas grave, à anticiper dans le cas d'une utilisation professionnelle.

-

diskstation va bientôt s'éteindre depuis 1 heure ...

.Shad. a répondu à un(e) sujet de mraskin dans Installation, Démarrage et Configuration

Par moments on n'a pas le choix, plus qu'à croiser les doigts. Normalement si le système a eu le temps d'arrêter une majorité de services ça limite les risques de dégradation des disques. Qu'a donné le redémarrage ? -

[SOS] Accès externe NAS sans passer par Quickconnect + Livebox Orange

.Shad. a répondu à un(e) sujet de Rohdan dans Installation, Démarrage et Configuration

J'avais testé pour un ami, ça marchait bien. Après pourquoi ça marchait, aucune idée. 😛 Disons toto.synology.me, j'ai créé un certificat LE via DSM pour ce nom de domaine, ainsi que audio.toto.synology.me, cam.toto.synology.me, etc... pour chacun de ses services que j'avais configurés dans le proxy inversé. Aucun message d'erreur durant la création de certificat, et j'étais bien en https quand j'accédais aux sous-domaines. Je soupçonne Synology de créer les CNAME nécessaires dans la zone DNS relative au nom de domaine qu'ils mettent à notre disposition quand on ajoute des entrées dans le proxy inversé ou dans le portail des applications de manière plus générale. J'avais testé ça dans l'update 3 de DSM 6.2.2, à vérifier si ça fonctionne avec la version actuelle. -

[SOS] Accès externe NAS sans passer par Quickconnect + Livebox Orange

.Shad. a répondu à un(e) sujet de Rohdan dans Installation, Démarrage et Configuration

Tu peux tout à fait créer des sous-domaines avec l'adresse fournie par Synology. -

[SOS] Accès externe NAS sans passer par Quickconnect + Livebox Orange

.Shad. a répondu à un(e) sujet de Rohdan dans Installation, Démarrage et Configuration

Tu as accès la zone DNS et ajouter les enregistrements que tu désires. Sur l'adresse fournie par Synology tu peux l'utiliser en tant que telle, et créer des sous-domaines, mais ça s'arrête là. -

C'est ce que j'ai moi. Dans contenu non lu.

-

Ecrasement des données à chaque sauvegarde ?

.Shad. a répondu à un(e) sujet de Félix Barloy dans Installation, Démarrage et Configuration

Bonjour, Tu utilises Drive pour synchroniser tes appareils ? Je pense que dans la console d'administration de Drive (paquet du centre de paquets) tu peux définir le nombre de versions que tu souhaites conserver pour tes différents partages. Je ne suis pas sûr que tu puisses partitionner le disque dur dans DSM. -

Contourner le blocage du port 25 chez orange pour utiliser Mail Plus ?

.Shad. a répondu à un(e) sujet de Suprême NAS dans Installation, Démarrage et Configuration

Ca t'aidera pas beaucoup je pense mais je suis confronté au même problème en Belgique avec Proximus, le port 25 est filtré et in-déblocable. La seule solution à ma connaissance est de louer les services d'un fournisseur SMTP, qui recevra sur le port 25 et renverra chez toi vers un port non filtré. -

Mes applications windows n'ont aucun mal à détecter mes vidéos et musiques sur les lecteurs réseau. Peut-être vérifier la version de SMB que tu utilises ?

-

Je pense exactement la même chose, et j'ajouterai également plusieurs points : Catégorie "Vos commentaires et suggestions" : Dans les faits c'est une catégorie qui sert de support, alors qu'une telle section ne devrait contenir que des tickets de suggestion, après qu'un problème ait été analysé, qu'on n'ait pas trouvé de solution avec le panel d'outils proposés par DSM et les améliorations qu'on aimerait y voir être apportées. Présentation : On est nombreux à rappeler le fait qu'on apprécie que les utilisateurs du forum se présentent avant de poser leurs questions. Plusieurs solutions : ne rendre visible l'ensemble du forum qu'une fois présenté ou par exemple qu'un inscrit non présenté ne puisse que consulter le forum (lecture seule). Dans les deux cas ça implique un travail supplémentaire de la part des modérateurs. Plus simplement on peut aussi envoyer automatiquement un MP aux nouveaux inscrits leur rappelant ce qu'on attend d'eux. En tout cas je pense que ce serait plus intéressant que de devoir systématiquement rappeler le fait à de nombreux nouveaux inscrits. Wiki : Historiquement il doit y avoir une raison, mais la section me paraît fort semblable à la section Tutoriels mais qui ressembleraient plus à des petits tutoriels, d'autant que la section contient aussi des demandes de support qui n'ont pas lieu d'y être. Vos commentaires sur les tutoriels : Aucune idée de l'utilité de cette catégorie, sauf si nos tutoriels étaient en lecture seule, ce n'est pas le cas et en plus l'outil de recherche permet de faire une recherche dans un sujet en particulier, même lorsqu'il y a plus d'une dizaine de pages. Installation, démarrage et configuration : La section la plus sollicitée du forum nécessite qu'on l'organise un peu mieux, avec des sous-catégories, une idée pourrait être de diviser suivant les domaines d'application : stockage, multimedia, etc... ce sont juste des pistes de réflexion, il faudrait y consacrer plus de temps. Manuel d'utilisation : ??

-

Utilité du raid 1 dans mon cas?

.Shad. a répondu à un(e) question de Niconaro49 dans Questions avant achat

Exactement. -

Juste une précision concernant ce modèle : Eaton Ellipse PRO 650 FR Les prises RJ45 sont compatibles 10/100 Mbps, oubliez donc la protection par Ethernet pour votre NAS. Honnêtement pour ce prix on pourrait avoir du gigabit...

-

Mise à jour de quelques étapes peu étayées. J'ai également supprimer la partie concernant la Fritz!Box, j'ai réussi à le faire mais en passant par collectd et non pas telegraf. Et ça ne concerne quasi personne. 🙂

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Codecs video pour serveur sous DSM 6.2 (DS713+)

.Shad. a répondu à un(e) sujet de budoka dans Logiciels Compatibles

De manière générale, l'idéal est que les codecs soient présents sur le périphérique de destination, ainsi le serveur n'a qu'à transmettre le flux tel quel. Donc oui à ta question, c'est ce que @PiwiLAbruti t'avait répondu plus haut. -

Codecs video pour serveur sous DSM 6.2 (DS713+)

.Shad. a répondu à un(e) sujet de budoka dans Logiciels Compatibles

Aucune idée, je ne connais pas tes TV, et ton message initial ne suggérait pas qu'il y en avait plusieurs. Ta deuxième TV donne un message d'erreur ? Si oui, le même qu'affichait la première avant la modification ? -

Je n'utilise pas ce logiciel, mais tu as bien utilisé ce template là en personnalisant avec tes données ? https://github.com/linagora/openpaas-esn/blob/master/docker-compose.yml Personnellement, au vu du nombre de ports à rediriger, du nombre de containers en lien, etc... je pense que tu aurais beaucoup plus facile d'utiliser Virtual Machine Manager, te créer une petite VM Linux avec sa propre IP dont la distrib est documentée sur le site d'OpenPaas, et de faire une installation classique.