-

Compteur de contenus

706 -

Inscription

-

Dernière visite

-

Jours gagnés

14

Tout ce qui a été posté par bruno78

-

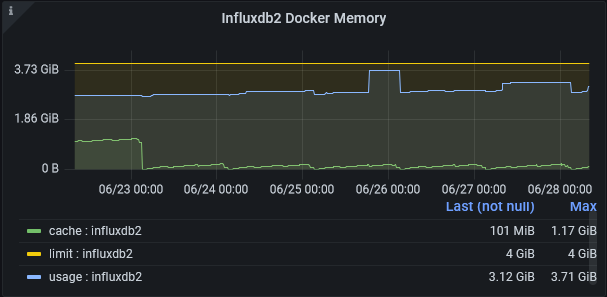

Bonjour @MilesTEG1, @.Shad., je suis sous Influxdb2 depuis plusieurs mois, .... et je n'ai vu aucune amélioration sur la consommation mémoire, toutes choses égales par ailleurs. Par ailleurs, je suis jaloux de la conso mémoire de @MilesTEG1. De mon côté, j'ai certes beaucoup (trop ?) de graphes et dashboards, mais ma conso mémoire est plutôt de l'ordre de 3.5GB !! Du coup j'ai été obligé de prendre une VPS à 8GB RAM, ce qui financièrement parlant ne tient pas la route. Je vais surement migrer influxdb2/grafana sur un RPI4 à 8GB ...

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

bruno78 a répondu à un(e) sujet de Einsteinium dans Tutoriels

Quelques explications ici : https://github.com/acmesh-official/acme.sh/wiki/Change-default-CA-to-ZeroSSL Où il est notamment précisé : Starting from August-1st 2021, acme.sh will release v3.0, in which the default CA will use ZeroSSL instead. This change will only affect the newly created(issued) certs after August-1st (with v3.0), any pre-existing certs will still be renewed automatically aginst the current CA. -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

bruno78 a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour, d'après ce que je vois dans les logs, zerossl est apparu pour la première fois lors de l’exécution du script le 14/juin, avec un upgrade en version 3.0.0. [Mon Jun 14 00:41:00 UTC 2021] ===Starting cron=== [Mon Jun 14 00:41:00 UTC 2021] Using config home:/acme.sh [Mon Jun 14 00:41:00 UTC 2021] ACME_DIRECTORY='https://acme-v02.api.letsencrypt.org/directory' [Mon Jun 14 00:41:00 UTC 2021] GET [Mon Jun 14 00:41:00 UTC 2021] url='https://api.github.com/repos/acmesh-official/acme.sh/git/refs/heads/master' [Mon Jun 14 00:41:00 UTC 2021] timeout= [Mon Jun 14 00:41:00 UTC 2021] _CURL='curl --silent --dump-header /acme.sh/http.header -L ' [Mon Jun 14 00:41:00 UTC 2021] ret='0' [Mon Jun 14 00:41:00 UTC 2021] Installing from online archive. [Mon Jun 14 00:41:00 UTC 2021] Downloading https://github.com/acmesh-official/acme.sh/archive/master.tar.gz [Mon Jun 14 00:41:00 UTC 2021] GET [Mon Jun 14 00:41:00 UTC 2021] url='https://github.com/acmesh-official/acme.sh/archive/master.tar.gz' [Mon Jun 14 00:41:00 UTC 2021] timeout= [Mon Jun 14 00:41:00 UTC 2021] _CURL='curl --silent --dump-header /acme.sh/http.header -L ' [Mon Jun 14 00:41:01 UTC 2021] ret='0' [Mon Jun 14 00:41:01 UTC 2021] Extracting master.tar.gz [Mon Jun 14 00:41:01 UTC 2021] default_acme_server [Mon Jun 14 00:41:01 UTC 2021] ACME_DIRECTORY='https://acme.zerossl.com/v2/DV90' [Mon Jun 14 00:41:01 UTC 2021] Skip install cron job [Mon Jun 14 00:41:01 UTC 2021] Using config home: /acme.sh [Mon Jun 14 00:41:01 UTC 2021] Installing to /root/.acme.sh [Mon Jun 14 00:41:02 UTC 2021] Installed to /root/.acme.sh/acme.sh [Mon Jun 14 00:41:02 UTC 2021] OK [Mon Jun 14 00:41:02 UTC 2021] Install success! [Mon Jun 14 00:41:02 UTC 2021] Using config home:/acme.sh [Mon Jun 14 00:41:02 UTC 2021] ACME_DIRECTORY='https://acme-v02.api.letsencrypt.org/directory' [Mon Jun 14 00:41:02 UTC 2021] GET [Mon Jun 14 00:41:02 UTC 2021] url='https://api.github.com/repos/acmesh-official/acme.sh/git/refs/heads/master' [Mon Jun 14 00:41:02 UTC 2021] timeout= [Mon Jun 14 00:41:02 UTC 2021] _CURL='curl --silent --dump-header /acme.sh/http.header -L ' [Mon Jun 14 00:41:02 UTC 2021] ret='0' [Mon Jun 14 00:41:02 UTC 2021] Upgrade success! [Mon Jun 14 00:41:02 UTC 2021] Using config home:/acme.sh [Mon Jun 14 00:41:02 UTC 2021] ACME_DIRECTORY='https://acme-v02.api.letsencrypt.org/directory' [Mon Jun 14 00:41:02 UTC 2021] Auto upgraded to: 3.0.0 Par contre, le script se déroule ensuite normalement, aucune demande d'enregistrement ni de directive particulière dans le fichier account. Le log indique clairement la directive suivante sans que je ne lui ai rien demandé explicitement ACME_DIRECTORY='https://acme-v02.api.letsencrypt.org/directory' Le script se termine ensuite normalement (en arrêt puisque date de renouvellement non atteinte, je n'ai pas fais le -force). Comportement identique sur 4 domaines utilisant cette même méthode . Bruno78 -

Release candidate disponible \o/ Version: 7.0-41882

bruno78 a répondu à un(e) sujet de Einsteinium dans Firmwares

@.Shad. @MilesTEG1, la bonne nouvelle avec Syno Photo en DSM7-RC (Synology Photo 1.0.0-0182), c'est que l'appli ainsi que ses réglages et dossiers est maintenant backupable via Hyper Backup. Ce n'était pas le cas jusque là avec la Beta. -

Release candidate disponible \o/ Version: 7.0-41882

bruno78 a répondu à un(e) sujet de Einsteinium dans Firmwares

Ok nickel 😄 J'attends ton retour 😉 @MilesTEG1 sans grande surprise, le script de création du MACVLAN au boot du NAS fonctionne impecc en DSM7-RC . -

Release candidate disponible \o/ Version: 7.0-41882

bruno78 a répondu à un(e) sujet de Einsteinium dans Firmwares

@MilesTEG1 je n'avais pas lu le script, mais je vois que tu utilises "synoservicecfg". A priori en DSM7 ce sera plutôt "synosystemctl" # synoservicecfg -ash: synoservicecfg: command not found # synosystemctl --help synosystemctl {COMMAND} ... Commands: start [--no-block] NAME... Start (activate) one or more units stop [--no-block] NAME... Stop (deactivate) one or more units enable NAME... Enable one or more unit files disable NAME... Disable one or more unit files restart [--no-block] NAME... Start or restart one or more units try-restart [--no-block] NAME... Restart one or more units if active reload [--no-block] NAME... Reload one or more units reload-or-restart [--no-block] NAME... Reload or restart one or more units reenable NAME... Reenable one or more unit files isolate [--no-block] NAME... Start one unit and stop all others mask [--runtime] NAME... Mask one or more units unmask [--runtime] NAME... Unmask one or more units uninstall NAME Remove units from system, as well as relating symlinks and flags daemon-reload Reload unit config get-default Get the name of the default target set-default NAME Set the default target get-enable-status NAME Get the enable status of given unit get-active-status NAME Get the active status of given unit get-load-status NAME Get the load status of given unit stop-service-by-reason REASON NAME... Stop one or more services by a reason start-service-by-reason REASON NAME... Start one or more services by a reason remove-service-reason REASON NAME... Remove reason for one or more services list-service-reason NAME List service reason get-unit-by-pid PID Get unit name that the pid belongs to list-service-by-mnt-path PATH List services using given mount path register-volume NAME VOLUME Register a volume for a unit package-register-volume NAME VOLUME Register a volume for a package unregister-volume NAME VOLUME Unregister a volume for a unit package-unregister-volume NAME VOLUME Unregister a volume for a package -

Release candidate disponible \o/ Version: 7.0-41882

bruno78 a répondu à un(e) sujet de Einsteinium dans Firmwares

@MilesTEG1 ce script fonctionne toujours parfaitement en DSM7 Beta. Pas encore passé en RC, mais je ne vois pas pourquoi il ne fonctionnerai plus .... Je te dis ... dans la journée peut-être ... -

[TUTO] Certificat Let's Encrypt avec acme.sh & api Ovh en Docker (DSM6/7) (Update 07/09/22)

bruno78 a répondu à un(e) sujet de Einsteinium dans Tutoriels

@MilesTEG1 bonjour, rien d'anormal à tous ces téléchargements. Une image Docker peut être composée de plusieurs "layers" suivant ce que le concepteur aura décider d'y intégrer. Quant à la fréquence d’exécution, de mon côté je le fais 1 fois par mois. Je n'ai pas vu d'effet secondaire négatif ... Cdt, Bruno78 -

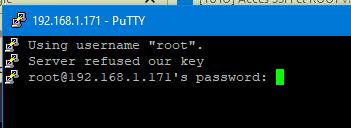

@GrOoT64 j'ai ça dans la clé publique (j'ai tronqué le milieu): bruno@ds918blam:~$ sudo -i Password: root@ds918blam:~# cat /root/.ssh/authorized_keys ---- BEGIN SSH2 PUBLIC KEY ---- Comment: "rsa-key-20210515" AAAAB3NzaC1yc2EAAAABJQAAAf8kQ9Tjubc3LnoB3fehcYe/adZDpuvRJL1pP0XU h3/GR/pvoCq107QkY85cwQaTNGGih/8Dfs3wfjO2v6r+unlyHoyOLoSoTdJIjaVd [......] DQbDEShnudMIRd7qxb/D28f1asNRj5piBqDqGn5IDZFJGd3I+MtzunUBN+boEMVK ETKt/0Zg2PPV9RvLwXxqfUzbXf+JF6cVn2zSXhKEpyFXEKQkm4z9FQjuTmGxdQ0f 9O4J ---- END SSH2 PUBLIC KEY ---- root@ds918blam:~# Question bête cependant : comment on sait si on est en "vrai" root ou pas ? J'ai un doute tout d'un coup .... @GrOoT64 OK c'est bon à présent, merci. Effectivement, il faut bien copier/coller ce qui est donné dans la fenêtre de puttyKey Generator, et rien d'autre. Donc OK. Mais, je n'y avais pas trop prêté attention, si je fais "simplement" un sudo -i depuis un compte admin, je semble me retrouver en vrai root sans passer par la clé ssh privée/publique ? est-ce une illusion ? comment le vérifier ? Synology strongly advises you not to run commands as the root user, who has the highest privileges on the system. Doing so may cause major damages to the system. Please note that if you choose to proceed, all consequences are at your own risk. bruno@ds918blam:~$ bruno@ds918blam:~$ bruno@ds918blam:~$ sudo -i Password: root@ds918blam:~# whoami root root@ds918blam:~#

-

@GrOoT64 content que cela fonctionne chez toi. Du coup j'ai tenté de régénérer une nouvelle paire de clés pour l'accès root au NAS, et j'ai invariablement un refus : Il me semble pourtant avoir suivi le Tuto correctement .... . je referai à tête reposée. Pour le FTPS, je ne sais pas trop a priori ... .

-

@GrOoT64 parfait ! Pour l'accès root, je vérifie cela dans la journée. Je l'ai fait, je suis sûr que ça marche, mais .... là il faut que je régénère un jeu de clé .... je ne suis pas dispo ce matin .... . J'ai fait un peu trop de ménage depuis .....

-

bonjour @GrOoT64, de ce que je viens de regarder, sous DSM7, les packages sont gérés via "systemctl" : bruno@ds918blam:~$ systemctl status sshd ● sshd.service - OpenBSD Secure Shell server Loaded: loaded (/usr/lib/systemd/system/sshd.service; enabled; vendor preset: disabled) Drop-In: /usr/lib/systemd/system/sshd.service.d └─synorelay-service-handler.conf Active: active (running) since Wed 2021-05-12 17:14:51 CEST; 2 days ago Main PID: 8225 (sshd) CGroup: /sshd.slice/sshd.service ├─ 4420 sleep 1 ├─ 4481 systemctl status sshd ├─ 8225 sshd: /usr/bin/sshd -D [listener] 0 of 10-100 startups ├─13125 sshd: bruno [priv] ├─13418 sshd: bruno [priv] ├─13419 sshd: bruno@pts/0 ├─13662 -sh ├─13732 sshd: bruno@notty ├─13733 sh -c while [ -d /proc/$PPID ]; do sleep 1;head -v -n 8 /proc/meminfo; head -v -n 2 /proc/stat /proc/version /proc/uptime /proc/loadavg /proc/sys/... └─13736 sshd: bruno@internal-sftp Mais si Synology a fait des utilitaires spécifiques, c'est qu'ils doivent bien faire quelque chose de plus ? Donc sous DSM7 il y a la commande Syno "synosystemctl" : bruno@ds918blam:~$ synosystemctl -h synosystemctl {COMMAND} ... Commands: start [--no-block] NAME... Start (activate) one or more units stop [--no-block] NAME... Stop (deactivate) one or more units enable NAME... Enable one or more unit files disable NAME... Disable one or more unit files restart [--no-block] NAME... Start or restart one or more units try-restart [--no-block] NAME... Restart one or more units if active reload [--no-block] NAME... Reload one or more units reload-or-restart [--no-block] NAME... Reload or restart one or more units reenable NAME... Reenable one or more unit files isolate [--no-block] NAME... Start one unit and stop all others mask [--runtime] NAME... Mask one or more units unmask [--runtime] NAME... Unmask one or more units uninstall NAME Remove units from system, as well as relating symlinks and flags daemon-reload Reload unit config get-default Get the name of the default target set-default NAME Set the default target get-enable-status NAME Get the enable status of given unit get-active-status NAME Get the active status of given unit get-load-status NAME Get the load status of given unit stop-service-by-reason REASON NAME... Stop one or more services by a reason start-service-by-reason REASON NAME... Start one or more services by a reason remove-service-reason REASON NAME... Remove reason for one or more services list-service-reason NAME List service reason get-unit-by-pid PID Get unit name that the pid belongs to list-service-by-mnt-path PATH List services using given mount path register-volume NAME VOLUME Register a volume for a unit package-register-volume NAME VOLUME Register a volume for a package unregister-volume NAME VOLUME Unregister a volume for a unit package-unregister-volume NAME VOLUME Unregister a volume for a package Donc dans ton cas 2 options a priori : via la commande native systemctl : systemctl restart sshd via la commande syno : synosystemctl restart sshd Cdt, bruno78 PS : et oui, le login root c'est toujours avec la clé ssh !

-

@RaZor83 merci pour ces évolutions. Si tu n'y vois pas d’inconvénient, elles seront intégrées (et te seront attribuées) dans ma prochaine édition du script (rien de planifié à ce jour). Cdt, Bruno78

-

Bonsoir, le script python pour le monitoring de la Freebox a été mis à jour, et est passé en version 061. Le Tuto a été mis à jour en première page. Je vous redonne le lien : https://github.com/bruno78310/Freebox-Revolution-Monitoring.git Les évolutions sont les suivantes : Prise en compte de l’agrégation de liens xdsl / lte-4g pour les Freebox Delta. Pour faire remonter ces compteurs, il faut invoquer le paramètre '-4' dans la liste des paramètres disponibles. Correction d'un bug lors de la demande de statistiques disques ('-D') sur une Freebox Mini4K qui n'a pas de disque. La demande faisait planter le script. Correction d'un bug lorsque l'état de la connexion est 'down' (paramètre 'state' lors de la requête sur la connexion) : dans ce cas, le script plantait. Désormais on positionne : media='None' ipv4='None' ipv6='None' ipv4_port_range=[0,0] Je remercie ici vivement @Galm et @Denisra76Frog qui m'ont prêté main forte pour valider cette évolution du script sur leur modèles respectifs de Fbox. Ainsi, le script est passé sur une Mini4K (fibre), une Delta (xdsl/4g) et une Révolution v2 (fibre). N'hésitez pas à me faire part de vos remarques. Cdt, bruno78

-

@adelac le problème n'est pas le transfert des données (des photos), mais de la base de données qui va avec : albums, regroupement visages, ... . Et comme Synology Photo ne propose pas (en espérant que ça vienne rapidement) de sauvegarde de l'application (donc de ses "réglages" ) .... . Le tout est de savoir si c'est acceptable de recréer à partir de zéro, ou si il faut transférer proprement l'environnement. J'ai commencé à regarder comment faire ce backup / restore de la base de données, mais je n'ai pas regardé comment discriminer selon tel ou tel utilisateur.

-

@Galm merci, je regarde à intégrer cela.

-

@Galm peux-tu m'indiquer les numéros de lignes, ou m'envoyer le fichier corrigé que j'intègre ces modifs dans la prochaine version ? Merci. (je vais sortir dans la semaine une version prenant en compte l’agrégation xdsl / lte, donc autant inclure ces maj.) @.Shad. oui c'est vrai que finalement, une fois passée la "surprise", ça fait sens.

-

Temps de réponse sites internet

bruno78 a répondu à un(e) sujet de frlevel dans Installation, Démarrage et Configuration

@frlevel en minutes !!!! as-tu des logs Apache et MariaDB ? PArce que là, effectivement, .... -

Temps de réponse sites internet

bruno78 a répondu à un(e) sujet de frlevel dans Installation, Démarrage et Configuration

Bonjour @frlevel, quand tu parles de temps de réponses "anormalement longs", on parle de dizaines de ms, de dizaine de secondes ? Je suppose que c'est mesuré en local ? Je suppose qu'avec Drupal il y a une gestion de cache ? Je commencerai à regarder par là. Quelle est ta configuration DS920 ? Utilisation de la mémoire ? saturation ? swap ? cache SSD MVNE ? bruno78 -

@RaZor83 Ok, dans ce cas, ... je retire ma remarque .... . C'est juste un peu déroutant si on ne connait pas ta convention. Cdt, Bruno78

-

@RaZor83 bonsoir, bonne idée de publier tes dashboards. Si je peux juste me permettre un commentaire, d'après les screenshots, une petite correction des dashboards serait nécessaire pour éviter les débits négatifs .... 🙂

-

@Jeff777 désolé de mon ignorance, mais pour mon info à quoi sert la carte SD de la POP ? Sinon je viens de passer en 4.3.0 ... et tout est remonté nickel 🙂 Je vais allez voir l'aide sur la documentation de l'API

-

@Jeff777 bonjour, a priori, je ne vois pas de rapport entre le changement de firmware de la box et la "perte" du dashboard. Jusqu'à présent à chaque redémarrage de la box et chargement d'un nouveau firmware, je n'ai pas eu a refaire le dashboard. D'ailleurs il faut que je la redémarre pour prendre cette maj. Il y a un point qui m'interesse (outre les résolutions de bugs et autres), c'est l'annonce de la maj. de la documentation de l'API v8 dans l'aide ....

-

@.Shad. non non, c'est toujours sous forme de code ..... Après je n'ai peut-être pas le tout dernier grafana ... alors je suis en 7.5.2, et la plus recente est une 7.5.4 qui vient de sortir, mais je ne vois rien dans le change log qui suggère une telle évolution ....

-

@Galm @arnostress merci pour votre retour, c'est toujours bien de voir qu'un travail est utile. Juste pour info, je suis en train de finaliser, avec @Denisra76Frog , une petite evolution du script permettant de remonter les compteurs dans le cas d'aggregation xdsl / 4G sur le lien uplink. Les dashboards, ... il y en plein partout, à commencer par ici sur ce forum. Et d'autre part, je suis maintenant entièrement passé sous influx-V2, qui demande une syntaxe de dashboard sous grafana assez différente de la version influx-V1. Mes anciens dashboards V1 sont sauvegardés quelque part .... :-). Par contre, si quelqu'un se lance sur influx-V2, je pourrai donner un coup de main. Cdt, bruno78