-

Compteur de contenus

706 -

Inscription

-

Dernière visite

-

Jours gagnés

14

Tout ce qui a été posté par bruno78

-

oui c'est possible, je vais (re)-vérifier ...

-

Bonjour @.Shad., merci d'avoir passé un peu de temps sur ce problème. J'ai aussi commencé par suivre strictement le tuto, et j'ai commencé par indiquer data_format = influx. D'ailleurs ce n'est pas clair en lisant les docs si on doit mettre influx ou influxdb. Ceci dit, cela n'a fonctionné avec aucunes de ces 2 valeurs. Donc j'ai provisoirement supprimé cette variable, et imposé "en dur" dans le script python de prendre le format influxdb Mais maintenant que j'y pense ..... c'est peut-être une erreur.. Je vais reprendre cela avec data_format = influxdb. En parallèle, je suis en train de tester une autre solution, à savoir faire tourner telegraf (sans docker) dans une VM mini ubuntu. Dés que je trouve une solution, je la poste .... Bruno78

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

Bonjour, un grand merci à @.Shad. pour ce tuto remarquablement précis et documenté. Je l'ai implémenté sans problème, à part mes propres erreurs .... . Ensuite, faut un peu naviguer pour maitriser Grafana .... mais au final on y arrive, même si on n'a pas les compteurs voulus du premier coup ! Ma question est ailleurs : emporté par l'élan, j'ai voulu implémenter le monitoring de ma Freebox Révolution. A priori cela doit être possible ? Et là je sèche !!! Je me concentre donc sur le docker "telegraf", qui collecte les données, puisque c'est lui qui me pose problème installation du docker 'telegraf' configuration supplémentaire à la main du docker 'telegraf' pour y inclure python, python3 en l’occurrence : mise à jour de la distribution root@dev_telegraf:/# apt update root@dev_telegraf:/# apt install software-properties-common installation du module 'pip' telecharger get-pip.py (https://bootstrap.pypa.io/get-pip.py) root@dev_telegraf:/usr/local/py# python3 get-pip.py --prefix=/usr/local installation du module python 'requests' root@dev_telegraf:/usr/local/py# python3 -m pip install requests à partir de là, on peut suivre le tuto de @.Shad. configuration du fichier telegraf.conf Résultat : les fichiers que l'on trouve sur GitHub sont relativement anciens. Je ne sais pas sur quelle version de Python ils tournaient. J'ai donc dû faire quelques modifications dans le fichier de commande freebox.py appelé par telegraf.conf. De même, quelques modifications dans la partie ajoutée spécifique à la Freebox dans telegraf.conf. Et l'API en cours sur le Freebox Révolution est maintenant en version 4, et non plus 3, ... au final, après ces modifications : association avec la Freebox OK toutes les commandes (via le script python lancé dans le docker telegraf) vers la Freebox sont OK et retournent les statistiques demandées par exemple : root@dev_telegraf:/usr/local/py# python3 freebox.046.py -f influxdb -S freebox,endpoint=mafreebox.freebox.fr bytes_down=78632745319 freebox,endpoint=mafreebox.freebox.fr switch_2_link=1 freebox,endpoint=mafreebox.freebox.fr switch_4_mode=3 freebox,endpoint=mafreebox.freebox.fr switch_1_link=0 freebox,endpoint=mafreebox.freebox.fr bytes_up=8388886152 freebox,endpoint=mafreebox.freebox.fr switch_4_link=1 freebox,endpoint=mafreebox.freebox.fr state=1 freebox,endpoint=mafreebox.freebox.fr rate_down=593 freebox,endpoint=mafreebox.freebox.fr rate_up=282 freebox,endpoint=mafreebox.freebox.fr switch_1_mode=1 freebox,endpoint=mafreebox.freebox.fr bandwidth_down=1000000000 freebox,endpoint=mafreebox.freebox.fr bandwidth_up=600000000 freebox,endpoint=mafreebox.freebox.fr switch_3_link=0 freebox,endpoint=mafreebox.freebox.fr switch_2_mode=3 freebox,endpoint=mafreebox.freebox.fr switch_3_mode=1 par contre, lorsque le script est lancé depuis le fichier de commande telegraf.conf: # Read metrics from one or more commands that can output to stdout [[inputs.exec]] ## Commands array commands = [ "python3 /usr/local/py/freebox_046.py -f influxdb" ] j’obtiens invariablement des erreurs du type : [inputs.exec] Error in plugin: invalid character '>' looking for beginning of value [inputs.exec] Error in plugin: invalid character '*' looking for beginning of value .... Je suis coincé à cette étape. Je ne sais pas comment investiguer, ni où, n'étant pas et de loin expert en python .... Je ne sais pas ce que sont ces caractères '*' ou '>' ni ce beginning of value .... Je suis donc à la recherche que quelqu'un ayant réussi à prendre sa Freebox Revolution en monitoring via telegraf ..... Ou d'un expert qui me dira tout de suite : "bon sang mais c'est bien sûr ....." et ce sera évident pour lui ..... 🙂 Je ne sais même pas quelles traces ou fichiers peuvent vous être utiles .... donc merci si vous avez des idées, je tiens les infos à disposition .... Bruno

- 1449 réponses

-

- snmp

- monitoring

-

(et 1 en plus)

Étiqueté avec :

-

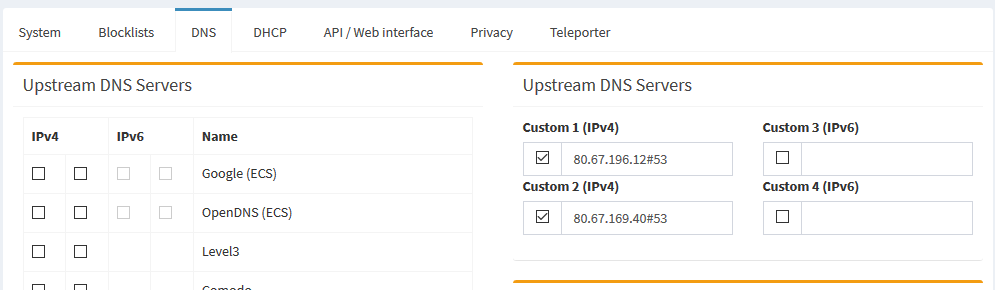

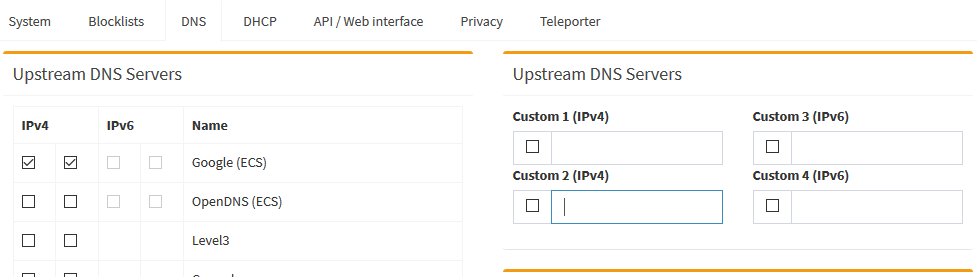

Bonjour @Dimebag Darrell désolé réponse un peu tardive, mais je recommence à regarder le fonctionnement de mon Pihole. Pour situer le contexte, je suis en PiHole sous Docker, utilisant le docker-compose, et en réseau macvlan. Pour les logs je ne sais pas, mais pour les répertoires j'ai monté les dossiers suivants dans mon fichier docker-compose.yaml : Cela permet de récupérer presque toute la config en cas de redémarrage et/ou re-installation. Je dis "presque" parce qu'il me reste un soucis non résolu : je n'arrive pas, suite à une réinstallation, à lui faire prendre en compte des DNS personnalisés ! je me retrouve systématiquement avec les DNS Google, et non pas les FDN comme souhaité. Il faut que je le fasse à la main. Suite à ré-installation : Puis modification à la main: A part cela, tous les autres paramètres (listes , .... ) sont bien récupérés automatiquement Cdt Bruno78

-

Débits faible et Livebox qui saute

bruno78 a répondu à un(e) sujet de radeise dans Installation, Démarrage et Configuration

je viens de refaire le même test ftp mais en filaire 1 Gbps cette fois avec 3 switches intermédiaires : 960 Mbps PC vers NAS, 700 Mbps NAS vers PC. Pour vérifier que tu n'as pas de problème de fonds, il faudrait pouvoir s'affranchir : 1) de la LB, 2) du Wifi. -

Débits faible et Livebox qui saute

bruno78 a répondu à un(e) sujet de radeise dans Installation, Démarrage et Configuration

La je viens de faire un test "à l'arrache" entre mon DS918+ (eth0 1Gbps) et un laptop "très moyen" en Wifi AC 5Ghz (link speed wifi à 585Mbps) à 5 mètres de la borne, j'obtiens en gros un débit montant ou descendant de l'ordre de 300 Mbps pour un fichier de 1.2 GBytes. Pas si mal copte tenu du link speed Wifi. Test en FTP avec Filezilla client sur le PC. -

Débits faible et Livebox qui saute

bruno78 a répondu à un(e) sujet de radeise dans Installation, Démarrage et Configuration

Pour autant que je puisse voir, Lan SpeedTest fonctionne soit en mode "shared folder", soit en mode advanced, c'est à dire client/serveur. Je suppose que tu utilises le mode "shared folder" ? as-tu la possibilité de faire un essai en FTP ? -

Débits faible et Livebox qui saute

bruno78 a répondu à un(e) sujet de radeise dans Installation, Démarrage et Configuration

Bonjour @radeise oui, dit comme cela, cela parait faible. Je procéderai par elimination si possible vérifier que l'interface Eth du NAS est bien à 1gbps. test en direct, le NAS le la MAC en filaire 1Gbps sur un switch giga ethernet autre que la LB. test via la LiveBox, en filaire 1Gbps (MAC et NAS) test dans ta configuration cible. Pour le plantage de la LB, ..... je ne suis pas chez le même fournisseur ..... je ne sais pas. Est'elle à jour ? Bruno -

Hello, bon alors je suis un peu têtu. J'ai cherché à savoir pourquoi la commande sort -ufo $tmp1 $tmp2 $tmp1 ne fonctionnait plus comme escompté dans ce script. Après de nombreuses tentatives et vérifications, je me suis aperçu que dans le fichier issu de cette commande sort -ufo $tmp1 $tmp2 $tmp1, les doublons toujours existants étaient de la forme : 94.191.68.83 94.191.68.83^M Je ne sais pas d'où cela vient car au départ, les 2 listes ne semblent pas contenir ce caractères parasites ... Donc, partant du constat qu'il n'y a aucune raison dans nos listes d'adresses de trouver des caractères autres qu'alphanumériques, j'ai rajouté l'option -d (-d, --dictionary-order consider only blanks and alphanumeric characters) à la commande sort. Au final, la commande devient donc : sort -ufdo $tmp1 $tmp2 $tmp1 Et il n'y a plus d'erreur d’exécution du script. Cela semble fonctionner nominalement. 🙂 Ci joint le fichier mis à jour. Bruno PS : n'étant pas expert malgré tout (juste têtu), si @PPJP ou quelqu'un d'autre plus expérimenté que moi pouvait faire une petite vérification du bon fonctionnement .... que je ne sois pas passé à côté de quelque chose d'autre .... Merci autoblocksynology.sh

-

Super, Merci @PPJP je pensais que ce n'étaient que des "warning", précisemment à cause des doublons. Je n'avais pas bien vu que le script était censé éliminer ces doublons avant ... Merci pour le nouveau script. Je vais le mettre en place rapidement .... peut-être après Noel quand même 🙂 J'en profite pour souhaiter des Joyeuses Fêtes de Noël et de fin d'Année à l'ensemble des membres de ce forum. Bruno

-

Rebonjour, (je me réponds partiellement) tout en guettant le forum, j'ai continué à chercher pourquoi ces messages d'erreur. Pour finalement m’apercevoir qu'ils étaient tout à fait "normaux". Je m'explique : j'utilise, comme dans le script, les 2 listes : https://lists.blocklist.de/lists/ et https://mariushosting.com/wp-content/uploads/2018/07/deny-ip-list.txt et donc il y a recombinaison de ces 2 listes en une seule, tout en interdisant les doublons ! (l'adresse IP est clé primaire dans la table sql, donc unique) en combinant les 2 listes à la main (enfin .xlsx), je m’aperçois que les erreurs remontées correspondent bien aux doublons résultant de la fusion des 2 listes. Donc OK Question subsidiaire pour être sûr de bien comprendre : A quoi exactement ce blocage d'adresses IP s'applique t'il ? A quelles applications ? Quel est sa valeur ajoutée par rapport au Pare-Feu ? Merci Bruno

-

Bonjour, un grand merci aux auteurs de ce script, que je viens de mettre en place. Une fois réglé le problème des saut de lignes dans le fichier, lancement du script, et hop un peu plus de 34000 ip listées dans les bloquées. J'ai néanmoins 1 problème dont je n'ai pas encore trouvé la source : Lors de l’exécution du script suivante, j'ai les messages d'erreur suivants : Le planificateur de tâches à terminé une tâche planifiée. Tâche : BlackList Internet Heure de début : Sun, 22 Dec 2019 12:55:02 GMT Heure d’arrêt : Sun, 22 Dec 2019 12:55:06 GMT État actuel : 0 (Normal) Sortie standard/erreur : Demarrage du script autoblocksynology.sh v0.0.2: Sun Dec 22 12:55:03 CET 2019 /tmp/autoblock_synology/fichiertemp1:21: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:54: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:58: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:94: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:96: INSERT failed: UNIQUE constraint failed: Tmp.IP ..... /tmp/autoblock_synology/fichiertemp1:34358: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:34675: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:34782: INSERT failed: UNIQUE constraint failed: Tmp.IP /tmp/autoblock_synology/fichiertemp1:34791: INSERT failed: UNIQUE constraint failed: Tmp.IP Script terminé Sincères salutations, Synology DiskStation Si vous avez des idées ou des pistes, .... Merci Bruno

-

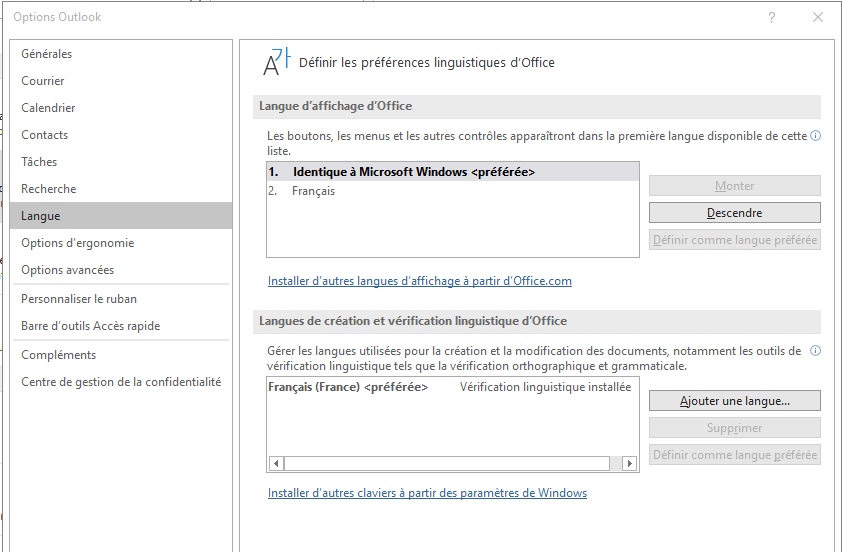

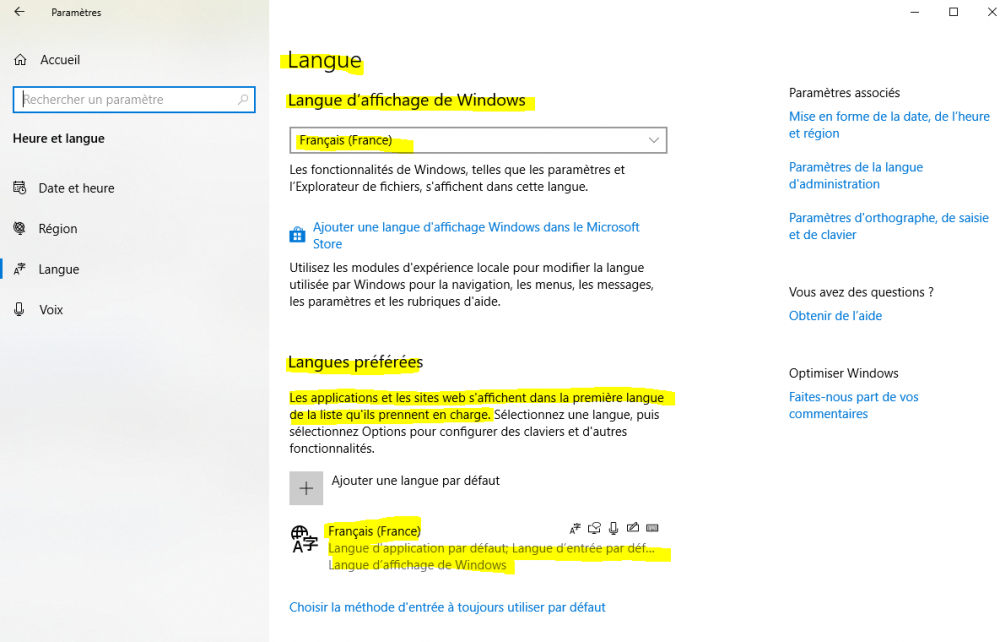

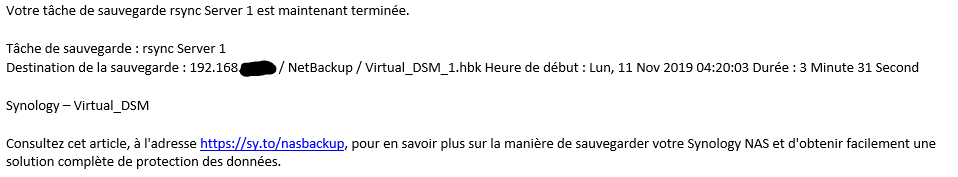

Bonjour @Fabweb, de mon côté j'utilise Outlook (Office 365) et reçois les notifications avec les bons caractères accentués en français. Côté DSM, idem, les options régionales sont positionnées en français. Côté Outlook, dans l'onglet Option > Langues, j'ai la config suivante : Ce qui m'amène à la question suivante : es-tu bien installé sur un Windows en Français ? A part ces vérifications, je ne vois pas trop. Avec ces réglages, voici le mail (dans Outlook) que j'ai reçu pas plus tard que ce matin : j'ai bien les accents .... A part les mails en provenance du Syno, reçois-tu des mails textes sur Outlook sans problème d'accentuation ? Bruno Question subsidiaire : as-tu la possibilité de faire le test avec un autre client mail que Outlook ?

-

Bonjour et bon dimanche, comme je suis un peu têtu, j'ai continué avec mes tests "badblocks". Je voudrais essayer de comprendre. D'autant que le sujet "préparation des disques" en général est important compte tenu de l'usage d'un NAS, et de la confiance que l'on doit pouvoir avoir si on tient à ses données (ce qui ne dispense pas bien sûr d'organiser les sauvegardes externes). J'ai refais le test avec un disque qui me sert de validation et pour des tests justement, donc non représentatif de ce que l'on mettrait a priori en production, et disque qui ne sert pas pour des données prod. Résultats : sans "-c" (par defaut, 16 blocks) : 40 heures 53 minutes, 0/0/0 errors avec "-c 98304" : 7 heures 30 minutes , 0/0/4 errors D'où les interrogations : quelle est la méthode la plus pertinente ? pourquoi cette différence ? quelle pourrait être l’influence de la taille du cache disque sur la valeur du "-c" à adopter ? Résultats bruts : Disque en test : Hitachi Disque Dur 500Go SATA 2.5" Travelstar 7K500 HTS725050A9A364 Pc Portable 16Mo Test sans le paramètre "-c" : badblocks -nvsf /dev/sda > /volume1/tmp/sda-20191026.log 2>&1 & /dev/sda is apparently in use by the system; badblocks forced anyway. Checking for bad blocks in non-destructive read-write mode From block 0 to 488386583 Checking for bad blocks (non-destructive read-write test) Testing with random pattern: 0.00% done, 0:00 elapsed. (0/0/0 errors) 0.00% done, 0:01 elapsed. (0/0/0 errors) <...> <...> 100.00% done, 40:53:49 elapsed. (0/0/0 errors) 100.00% done, 40:53:50 elapsed. (0/0/0 errors) 100.00% done, 40:53:51 elapsed. (0/0/0 errors)done Pass completed, 0 bad blocks found. (0/0/0 errors) Test avec le paramètre "-c" : badblocks -nvsf -c 98304 /dev/sda > /volume1/tmp/sda-20191026.log 2>&1 & /dev/sda is apparently in use by the system; badblocks forced anyway. Checking for bad blocks in non-destructive read-write mode From block 0 to 488386583 Checking for bad blocks (non-destructive read-write test) Testing with random pattern: 0.00% done, 0:01 elapsed. (0/0/0 errors) 0.00% done, 0:03 elapsed. (0/0/0 errors) <...> 0.50% done, 1:54 elapsed. (0/0/0 errors) 2491200 2491201 2491202 2491203 0.50% done, 1:56 elapsed. (0/0/4 errors) 0.52% done, 1:58 elapsed. (0/0/4 errors) <....> 99.98% done, 7:30:06 elapsed. (0/0/4 errors) 99.98% done, 7:30:08 elapsed. (0/0/4 errors) 100.00% done, 7:30:09 elapsed. (0/0/4 errors)done Pass completed, 4 bad blocks found. (0/0/4 errors) Et pendant ce temps là, mon "badblocks" sans le paramètre "-c" sur mon disque WD 6To continue son petit bonhomme de chemin : on est parti pour 6 à 8 jours .... . Je le laisse tourner tranquillement. 0/0/0 errors pour le moment à 25% done.

-

@firlin J'ai trouvé une descrition suivante pour le paramètre "-c". -c nombre-de-blocs est le nombre de blocs à tester en une fois (16 par défaut). Accroître ce nombre augmentera l'efficacité de badblocks mais également son utilisation mémoire. Les besoins en mémoire de badblocks sont proportionnels au nombre de blocs à tester simultanément en mode lecture-seule, à deux fois ce nombre en mode lecture-écriture, et à trois fois ce nombre en mode lecture-écriture non destructif. Si vous fixez le paramètre nombre-de-blocs à une trop grande valeur, badblocks se terminera presque immédiatement sur une erreur manque-de-mémoire « lors de l'allocation de tampons mémoire » ; si vous le fixez trop bas pour un test en mode-écriture-non-destructif, alors il est possible que des blocs douteux présents sur un disque dur non fiable soient masqués par les effets du tampon de pistes du disque dur. Du coup, je n'ai pas interrompu le test en cours sur mon disque de 6To, mais j'ai relancé un test sur un autre disque, 500Go, avec le paramètre "-c 98304". oui cela semble nettement plus rapide. par contre, badblocks me sort quelques blocs en erreur, alors que le test sans l'option -c n'a donné aucune erreur. J'attends la fin des tests pour conclure ....

-

Bonjour @firlin, j'ai inséré le disque neuf dans le slot #2 libre de mon Syno (arrêt du Syno puis redémarrage même si il support le hotswap) redémarrage Syno la led du disque #2 inséré passe verte, le disque apparait à l’état "non initialisé", état de santé "normal" dans le DSM je fais un test SMART rapide => RAS en putty, je lance la ligne de commande suivante : badblocks -nvs /dev/sdb > /volume1/toto/sdb-20191024.log 2>&1 & je n'ai effectivement pas précisé le paramètre " -c 98304", il m'avait semblé à la lecture des différents posts que l'effet était marginal. Peut-être aurais-je dû l'utiliser ? Ce matin, process toujours en cours : Checking for bad blocks in non-destructive read-write mode From block 0 to 1565555287 Checking for bad blocks (non-destructive read-write test) Testing with random pattern: 19.97% done, 37:31:28 elapsed. (0/0/0 errors)

-

Bonjour, je viens de lancer hier soir un test badblocks sur un disque neuf WD Red 6To, et il me donne : Checking for bad blocks in non-destructive read-write mode From block 0 to 1565555287 Checking for bad blocks (non-destructive read-write test) Testing with random pattern: 9.77% done, 16:12:59 elapsed. (0/0/0 errors) Bon, j'en ai pour une petite semaine ... D'un autre côté, pas d'impact sur le NAS, pas de ralentissement, pas de charge CPU ni de consommation de mémoire. Cela ne doit même pas être trop stressant pour le disque, car il continue à m'afficher une température de 29°c, comme pour les autres disques en service. Faut juste être patient 😁

-

OK je comprends pour l'utilisation VDSM.Tu as mis en œuvre la VDSM pour de multiples services, et du coup tu en as logiquement profité pour y placer également PiHole. N'ayant pas déployé de VDSM, c'est peut-être excessif de la déployer juste pour y installer PiHole ? Après, plus globalement, je vais me poser la question effectivement d'une VDSM pour ne pas exposer le NAS directement sur Internet. Ce sera un autre chantier. Pour les listes, oui, effectivement, j'ai à peu de choses près trouvé les mêmes listes. Donc OK. Mais c'est vrai qu'avoir un lieu qui les centralise, c'est bien. Côté whitelists, j'ai utilisé les listes "anudeepND commonly accepted whitelist" et "anudeepND whitelist optional" (partiellement). Quoi qu'il en soit, je vais observer quelques temps pour trouver le réglage optimal.

-

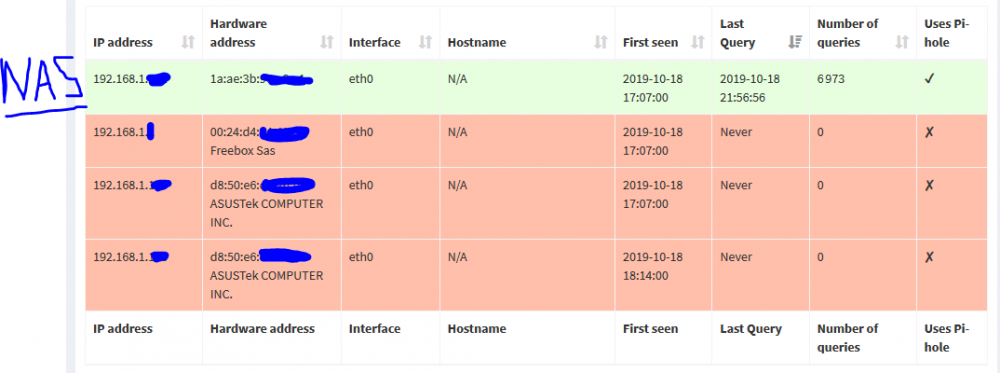

Bonsoir, pour la liste des clients visibles sur le docker Pihole, clairement on ne voit que l'adresse IP attribuée au réseau macvlan du NAS : Il faudrait que je ressorte le Raspberry PI du tiroir pour voir si le comportement est différent. L'idée de faire un VDSM et de mettre le PiHole dessus : c'est une idée. Est-ce que cela présente des avantages particuliers ? Avez-vous des conseils particuliers pour les listes black & white ?

-

Bonjour, j'ai monté une configuration équivalente : DNS server sur le Syno les équipements du LAN s'adressent au DNS server du Syno pour les requêtes DNS du coup, le Syno gère les requêtes locales le DNS Server du Syno transmet ses requêtes vers le PiHole PiHole server : hébergé dans un container Docker sur le Syno reçoit les requêtes du DNS server du Syno forwarde les requêtes vers les DNS externes (FDN) le serveur DHCP sur le réseau est supporté par la Freebox. Et donc effectivement, le seul client visible du PiHole, c'est le DNS Server du NAS. En cas de plantage du Syno, alors de grandes chances qu'à la fois le DNS server Syno et le PiHole server hebergé soient plantés. Dans ce cas, les équipements du LAN se rabattent sur le second DNS server proposé via le DHCP de la Box. Configuration en place depuis quelques jours, opérationnelle depuis quelques heures 🙂 A priori ça marche bien. Il faut que je continue à observer. En fait, ce sont maintenant surtout les blacklist / whitelist qu'il faut ajuster pour bloquer le contenu indésirable, tout en préservant la navigation licite. et dés que l'on est dans le monde Google/Youtube, ..., de plus en plus difficile de supprimer les pubs ou les trackers sans en même temps se couper du service .... Reste également (mais c'est un autre sujet) à ajuster les paramètres du docker PiHole pour assurer la persistance des données lors d'upgrade de l'image Docker la plus automatisée possible ....

-

Bonjour, je me réponds et precise : je viens de faire l'essai avec driver macvlan selon la méthode du fichier yaml avec le docker-compose, et toujours la même erreur : root@ds918blam:/volume1/docker/config_json_yaml# docker-compose up -d root@ds918blam:/volume1/docker/config_json_yaml# docker-compose up -d Creating network "config_json_yaml_pihole_network" with driver "macvlan" Creating pihole-pihole1 ... error ERROR: for pihole-pihole1 Cannot start service pihole: b'failed to create the macvlan port: device or resource busy' ERROR: for pihole Cannot start service pihole: b'failed to create the macvlan port: device or resource busy' ERROR: Encountered errors while bringing up the project. root@ds918blam:/volume1/docker/config_json_yaml# je suis démuni ....

-

Bonjour, je suis avec intérêt ce tuto pour mettre en place un PiHole dans un docker, en utilisant le driver macvlan. A priori le Network est bien créé : # docker network create -d macvlan --subnet=192.168.1.0/24 --gateway=192.168.1.1 --ip-range=192.168.1.248/30 -o parent=eth0 pihole_lan root@ds918blam:~# docker network list NETWORK ID NAME DRIVER SCOPE 02a068d9d7b0 bridge bridge local 27be936ed30b host host local 5144054d304c none null local 136d6e35aab1 pihole_lan macvlan local root@ds918blam:~# et il apparait bien dans l'interface réseau de Docker : et le container est bien configuré sur ce réseau : Néanmoins et j'en viens à mon problème : impossible de démarrer ce container. => message erreur de Docker : "message":"failed to create the macvlan port: device or ressource busy" J'avoue ne pas comprendre ni avoir trop de piste pour investiguer. Je n'ai pas utilisé le "docker-compose" mais si nécessaire je le ferai, mais j'aimerai bien comprendre ici pourquoi cela ne fonctionne pas. Merci d'avance bruno78

-

[TUTO] Anti-Pub avec le paquet Proxy Server

bruno78 a répondu à un(e) sujet de Einsteinium dans Tutoriels

Bonjour, merci pour ce tuto, grâce auquel j'ai pu mettre en œuvre le package proxy, ainsi que le filtrage anti-pub, avec Maj. du fichier adservers.reg sur une base quotidienne. Cela semble fonctionner plutôt pas mal, néanmoins quelques interrogations : où se trouve et comment gère t'on le fichier log de filtrage ? j'ai bien vu comment l'exporter, mais je n'ai pas vu son emplacement sur le NAS. comment ce fichier est il purgé ? comment limiter sa taille ? mise à jour du "adservers.reg" : le script fonctionne bien a priori. La date du fichier est bien mise à jour à l'heure d’exécution du script. Néanmoins là non plus je ne trouve pas trace dans le log /var/log/packages/ProxyServer.log des arrêts et redémarrage du serveur proxy (commande /var/packages/ProxyServer/scripts/start-stop-status stop et /var/packages/ProxyServer/scripts/start-stop-status start du script de mise à jour). A priori le script ne me retourne pas d'erreur d’exécution. Merci pour vos lumières et conseils avisés. Bruno78 -

Bonjour, ne pas oublier de modifier le registre windows : Si votre NAS est derrière un routeur-NAT (une box par exemple), il faut créer la valeur de registre suivante : https://support.microsoft.com/en-us/kb/926179 Clef : HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\PolicyAgent Valeur DWORD32 : AssumeUDPEncapsulationContextOnSendRule Donnée de la valeur : 2 et on reboot le PC Je pense que cela devrait régler ton problème.

-

Site internet Synology

bruno78 a répondu à un(e) sujet de breaker85 dans Installation, Démarrage et Configuration

Bonjour breaker85, je vois que tu as utilisé Wordpress : selon quelle méthode ? Pour l'avoir mise en œuvre tout en étant (relativement) débutant, tu peux utiliser l'excellent tuto qui lui-même fait référence au tuto complet dispo ici : http://bit.ly/wp_DSM Si on suit les instructions à la lettre, cela fonctionne sans problème. On obtient une installation Wordpress en français (ou en ce que tu veux puisque c'est toi qui décide de l'archive WordPress que tu installes ) totalement fonctionnelle, sans aucune restriction. Cela permet également d'installer plusieurs sites du ton NAS, chacun étant hébergé dans une instance séparée et autonome d'un VirtualHost sur ton NAS. Bon courage.