-

Compteur de contenus

50 -

Inscription

-

Dernière visite

À propos de Double Jo

.png.96b3b3865e7602c8e02642dcb636f80b.png)

Visiteurs récents du profil

Le bloc de visiteurs récents est désactivé et il n’est pas visible pour les autres utilisateurs.

Double Jo's Achievements

-

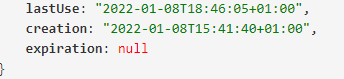

Bon je décris ce que j'ai fait si ça peut aider des gens. Je suis allé vérifier si mes clés OVH étaient expirées (dans mon souvenir je n'avais pas mis de date d'expiration) L'API OVH me confirme qu'il n'y a pas de date: oracle7 m'a dit que les 3 clés OVH étaient stockées dans le fichier /usr/local/share/acme.sh/account.conf Or je n'avais que SAVED_OVH_AK et SAVED_OVH_AS. Pas de OVH_CK donc. Dans le code source du script ACME pour OVH, ici: https://github.com/acmesh-official/acme.sh/blob/15c68c95940620f1db1b9b5704e730f681ad2f9c/dnsapi/dns_ovh.sh#L95 On voit qu'il supprime la variable OVH_CK s'il détecte un changement de clé. Ça expliquerait l'absence de valeur de mon côté. Je l'ai simplement remise, j'ai relancé et c'est reparti. Je n'explique pas sa suppression.

- 937 réponses

-

- letsencrypt

- certificat

-

(et 1 en plus)

Étiqueté avec :

-

Merci, je pense que tu as raison 🙂 Je viens de me connecter en ssh, via le compte root et je m'étonne que quand je fais un "env", je ne vois pas les 4 variables d'environnement OVH dans la liste (OVH_AK, OVH_CK, ...) Pourtant lors du tuto on a bien fait un "export" des ces 4 variables. Tu sais où elles atterrissent?

- 937 réponses

-

- letsencrypt

- certificat

-

(et 1 en plus)

Étiqueté avec :

-

Bonjour. Vous aussi du jour au lendemain vous avez eu ce genre d'erreur (je suis chez OVH)? [Sun Feb 20 01:00:17 CET 2022] error {"message":"This credential is not valid","httpCode":"403 Forbidden","errorCode":"INVALID_CREDENTIAL"} [Sun Feb 20 01:00:17 CET 2022] The consumer key is invalid: tUg4erO1sSTK3ye7itSwoYbsLhYwYPyL [Sun Feb 20 01:00:17 CET 2022] Please retry to create a new one.

- 937 réponses

-

- letsencrypt

- certificat

-

(et 1 en plus)

Étiqueté avec :

-

Modifier les profils de contrôle d'accès en ligne de commande

Double Jo a répondu à un(e) sujet de Double Jo dans Installation, Démarrage et Configuration

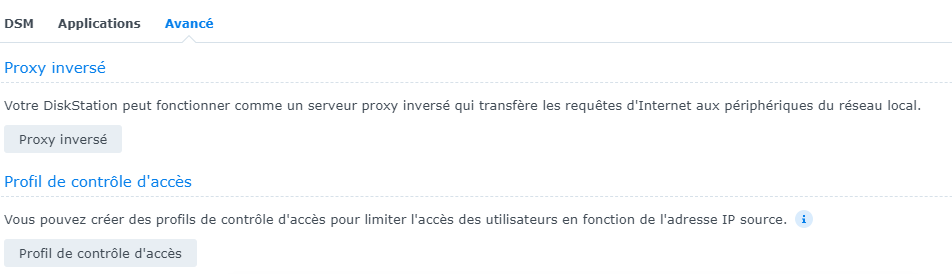

Merci mais j'ai dû mal m'exprimer. J'ai fais tout ce que tu décris @oracle7. Pour être plus précis j'ai un conteneur docker qui tourne avec une API Python qui écoute. J'ai envie de limiter l'accès aux requêtes dont l'ip source est mon ip publique. Aujourd'hui, j'arrive à faire ça en changeant à la main la rule dans le "profil de contrôle d'accès". J'ai juste envie d'automatiser le truc en le scriptant d'où ma demande pour savoir s'il y a une commande qui fait ça! -

Je pense que c'est bon finalement. En fait j'ai précisé 3 domaines lors du "issue". Les 2 premiers étant mon domaine1 et sa wildcard. Le 3ème paramètre est donc mon domaine2. Lors du deploy, il m'a fallu absolument mettre la variable export SYNO_Create=1 Car en fait il va créer un second certificat (dans la fenêtre des certificats du panneau de config Syno) avec comme description mon domaine2. Là du coup c'est passé. Dans le panneau de config donc, je me retrouve avec 2 certifs visibles, qui ont le même nom. Le premier a une description vide (certif par défaut) Le second a comme description mon second ndd. Je lui ai ensuite associé le service web qui doit utiliser ce certificat. J'avoue que je suis étonné, je m'attendais à ne voir qu'un certif dans le panneau de config. J'ai un doute quand même... Je me demande si ce comportement n'est pas un effet secondaire de tous mes tests. Parce que la description de ce "second" certifcat n'est pas "mondomaine2.com", mais juste "Mondomaine2" C'est à dire sans le ".com" et avec une majuscule. Et c'est exactement la description que j'avais mis lorsque j'ai essayé de déployer mon autre certificat quand je voulais en créer plusieurs.

- 937 réponses

-

- letsencrypt

- certificat

-

(et 1 en plus)

Étiqueté avec :

-

Je me répond à moi même et oui ce n'est pas la bonne méthode. Je pense qu'il faut plutôt ajouter un paramètre "-d" lors du "issue": ./acme.sh --issue --keylength 4096 -d "$CERT_DOMAIN" -d "$CERT_WDOMAIN" -d "$CERT_OTHER_DOMAIN" --dns "$CERT_DNS" Il devrait alors créer un certificat valable pour tout les ndd précisés en paramètre. Par contre je galère pour les déployer ensuite.

- 937 réponses

-

- letsencrypt

- certificat

-

(et 1 en plus)

Étiqueté avec :

-

Merci pour tout ça marche nickel! Je suis sous DSM 7 et au niveau de la tâche planifiée j'ai fait ce que tu as écrit dans la conversation, c'est à dire ne pas utiliser python et mettre direct: bash /usr/local/share/acme.sh/acme.sh --cron --force --debug --home /usr/local/share/acme.sh/ Question: J'ai 2 ndd à renouveler. Les 2 sont chez OVH et les clés OVH que j'ai généré sont valables poru tous les ndd. Je me suis dit qu'il suffisait que je crée 2 tâches planifiées qui ressembleront à ça: export CERT_DOMAIN="votre-domaine.tld" export CERT_WDOMAIN="*.votre-domaine.tld" export SYNO_Certificate="" bash /usr/local/share/acme.sh/acme.sh --cron --force --debug --home /usr/local/share/acme.sh/ export CERT_DOMAIN="votre-domaine2.tld" export CERT_WDOMAIN="*.votre-domaine2.tld" export SYNO_Certificate="Autre certif" bash /usr/local/share/acme.sh/acme.sh --cron --force --debug --home /usr/local/share/acme.sh/ Mais le second certificat a le nom du premier donc mes "export" semblent pas suffisant. Même si pourtant le second certificat a bien la description "Autre certif"... Qu'en penses-tu?

- 937 réponses

-

- letsencrypt

- certificat

-

(et 1 en plus)

Étiqueté avec :

-

N'importe quel sous domaine mène au dossier "web"

Double Jo a répondu à un(e) sujet de Double Jo dans Installation, Démarrage et Configuration

Ah ok tout simplement... Merci ! -

Pourquoi j'aurais besoin du DS918+ si le DS418+ existe?

Double Jo a répondu à un(e) question de Double Jo dans Questions avant achat

Ah oui mon exemple est le même concernant les DS420+ et DS920+ effectivement. Donc si je comprends bien, le DS920+ propose la possibilité de mettre une extension, mais surtout de la puissance supplémentaire. Il se trouve que je me sers beaucoup de docker, mais j'ai pas tellement besoin d'espace. Et d'ailleurs j'hésite à prendre un "vrai" serveur, pas un NAS. Voir partir dans le cloud. Qu'en pensez-vous? -

Pourquoi j'aurais besoin du DS918+ si le DS418+ existe?

Double Jo a posté une question dans Questions avant achat

Bonjour! J'ai actuellement le DS218+ et j'en suis ravi. Je souhaite passer sur un 4 baies et j'ai été étonné de voir qu'au delà du DS418+, il existe des NAS avec possibilité d'extension, le DS918+ par exemple. Je ne comprends pas ce que ça apporte. Si j'ai besoin de plus d'espace, pourquoi ne pas se contenter du DS418+ avec des disques durs plus gros? -

Salut. Petit à petit je m'en sors avec la conf de mes domaines. J'ai deux domaines chez OVH et chacun d'eux me redirige vers mon NAS avec la conf DDNS. OVH Côté OVH, pour les 2 domaines, j'ai un truc comme ça: *.mondomaine1.fr. CNAME mondomaine1.fr. www.mondomaine1.fr. CNAME mondomaine1.fr. Parfait. NAS Côté NAS, j'ai à la fois le reverse proxy, et des virtual hosts. Reverse proxy Pour le reverse proxy j'ai quelques entrées pour des sous domaines particuliers, du genre: calendar.mondomaine1.fr drive.mondomaine1.fr mondomaine1.fr qui redirige vers le port 5000 pour le DSM ... Et rien concernant mondomaine2 ici Virtual hosts Et pour les virtual hosts, j'en ai 2: truc.mondomaine1.fr qui mène au sous dossier mondomaine1 mondomaine2.fr qui mène au sous dossier mondomaine2 Et donc le répertoire root "web" n'est pas censé être utilisé car rien ne redirige vers lui. Le problème Pour les 2 domaines, quand je saisi une adresse avec un sous domaine, n'importe lequel qui n'est pas traité par le reverse proxy, par exemple: https://sdjhfrjkdfhdjkh.mondomaine1.fr https://toto.mondomaine2.fr Je suis redirigé vers le dossier "web" de web station. Ce que je souhaite: Ça me paraîtrait logique de tomber sur une 404 à la place. On ne peut pas désactiver le dossier web pour ne laisser que les virtual hosts? Merci!

-

(Développement) Certificat LE sur une API python docker

Double Jo a répondu à un(e) sujet de Double Jo dans Installation, Démarrage et Configuration

Ok fausse alerte, il fallait mettre un "/" à la fin de ma route... -

(Développement) Certificat LE sur une API python docker

Double Jo a répondu à un(e) sujet de Double Jo dans Installation, Démarrage et Configuration

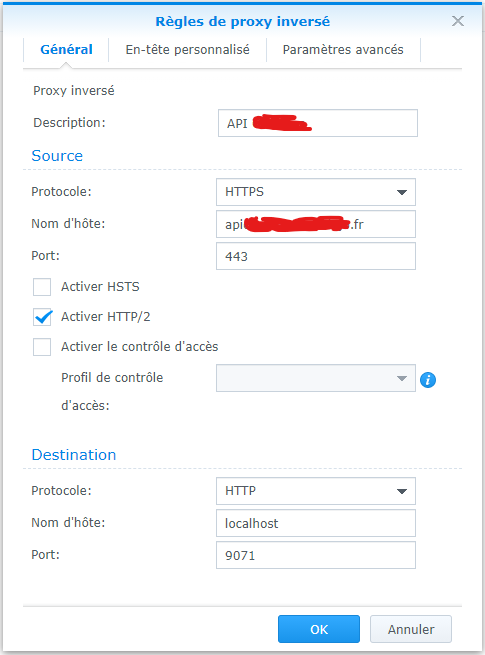

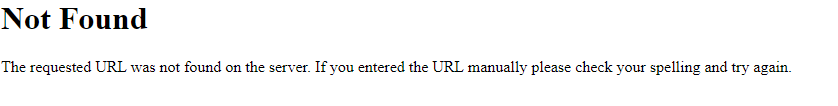

J'ai eu une réponse sur StackOverflow. Le mec disait que je devrais plutôt utiliser le reverse proxy (qui lui bénéficie du certificat facilement) afin de rediriger les requêtes du front vers l'api. Les appels à l'api seraient donc uniquement en local et n'ont pas besoin d'être en https. J'ai donc créé une nouvelle entrée dans le reverse proxy, comme ceci (pj) Mais je tombe sur une 404 Le port 9071 est bien celui sur lequel je dois taper, car ça fonctionne quand j'indique l'adresse ip du NAS suivie du port. Pour info, la 404 que j'ai est au "style" Synology. Alors que quand je fais une erreur volontaire dans l'url, j'ai une 404 au style plus classique (voir pj) Qu'en pensez-vous? Style Synology: Style "classique": -

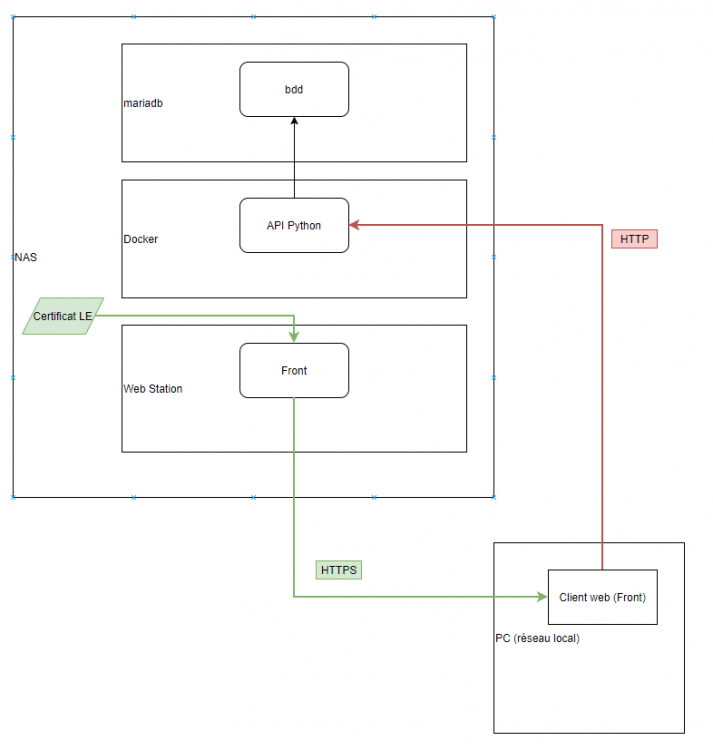

Salut! Il s'agit d'un problème à mi-chemin entre le développement et la gestion de notre NAS, j'espère que je poste au bon endroit. J'ai développé une petite API python qui tourne dans un container docker sur le nas. Cette API fait des requêtes sur une base mariadb, également sur le nas. Mais (et c'est là l'intéressant) j'ai également fais une page web (vue-js) qui interroge l'api python. Tout ça marche bien, mais je souhaite appliquer du HTTPS. Voici (en pj) le schéma de ma situation. J'ai un certificat LE, je m'en sers déjà pour sécuriser l'accès au DSM par exemple. J'ai réussi à l'utiliser pour avoir du HTTPS sur mon appli vue-js. Le problème c'est qu'il faut également du HTTPS entre l'appli vue-js, et l'api python maintenant, et là je galère. Puis-je utiliser le même certificat? Comment je le "donne" à l'api? Pour info, l'api est en python donc. C'est une appli Flask et le serveur est gunicorn. J'ai réussi à mettre le https pour les test en local, en ajoutant ssl_context = 'adhoc': def main(): app.run(host='0.0.0.0', ssl_context='adhoc') Mais une fois livré dans docker ça ne fonctionne plus: time out. Je suis un peu perdu.