Rechercher dans la communauté

Affichage des résultats pour les étiquettes 'hyperbackup'.

8 résultats trouvés

-

Bonjour la communauté. Je teste actuellement la solution Kdrive Solo 2Tera (Infomaniak). La connexion se fait très bien en webdav avec Hyperbackup. Ma question est la suivante : Les CGU indiquent que le Max de data par jour est limité à 200Gb. Partant de cette limite, il devient impossible de l...

- 2 réponses

-

Chers tous, Je vous fait partager mon expérience avec pCloud. J'ai souscrit un abonnement à vie de 2To, financièrement intéressant quand on a pas la possibilité d'héberger un NAS de sauvegarde chez quelqu'un d'autre. La sauvegarde du NAS peut se faire via HyperBackup, via WebDAV. Le p...

- 25 réponses

-

- hyperbackup

- cloud

-

(et 3 en plus)

Étiqueté avec :

-

Hello le forum ! Je souhaite sauvegarder des répertoires de mon DS918+ vers un DS218J avec Hyper Backup et Hyper Vault. Cependant j'obtiens une erreur : [Network][Synology NAS 1] Exception occurred while backing up data. (Destination quota at destination is insufficient. Please expand your t...

-

- hypervault

- hyperbackup

-

(et 1 en plus)

Étiqueté avec :

-

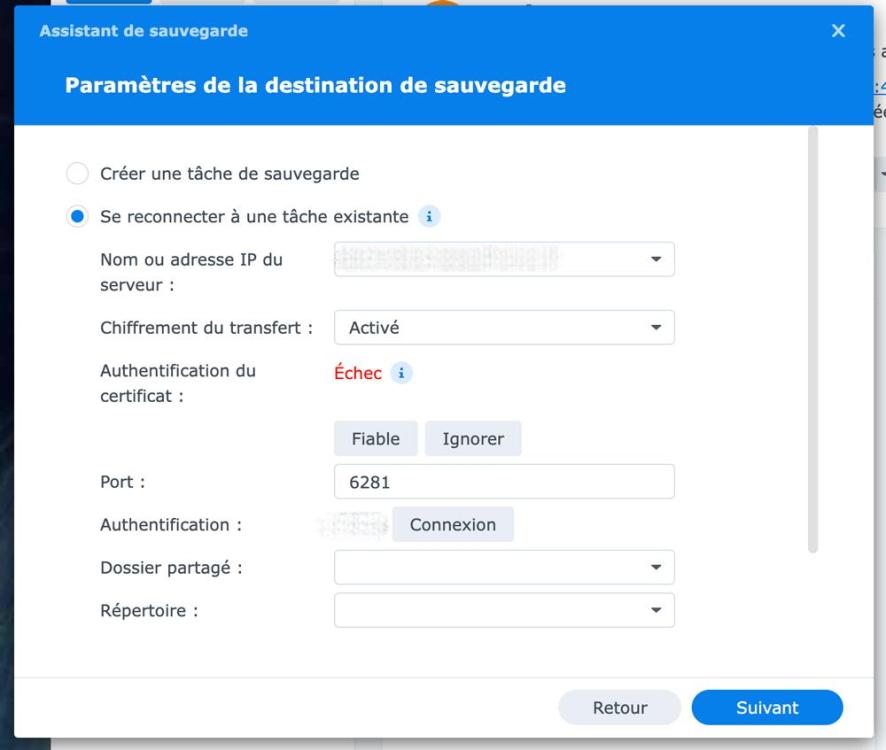

Bonjour et d'avance merci du temps que vous accorderez à la lecture de mon thread. 🙏 Historiquement, j'effectue depuis 5 ans un backup en local de mes données d'un NAS(1) vers un second NAS(2). Tout se passait très bien jusqu'ici. Aujourd'hui j'ai la possibilité d'externaliser mon b...

- 6 réponses

-

- chiffrement

- backup

-

(et 3 en plus)

Étiqueté avec :

-

Bonjour et meilleurs vœux à tous 🎉, J'ai une petite question ❓concernant la MAJ de DSM 6.2.4 vers DSM 7.0.1 à destination de ceux qui ont fait le grand saut. Il y a maintenant 10 ans que j'utilise différents Syno avec les mêmes DD et je n'ai jamais fait de réinstallation malgré les multip...

- 1 réponse

-

- hyperbackup

- dsm6

-

(et 1 en plus)

Étiqueté avec :

-

Hello, Ce matin j'ai une tâche Hyperbackup en échec Je suis en train d'investiguer pour comprendre, et de faire d'autres essais. Mais si parmi vous, certains ont déjà eu ça, je suis preneur de votre expérience. la tâche en question est programmée le mardi, le jeudi et le samedi à 2h40 pou...

-

Bonsoir, J'aurais besoin des pros du rclone ou rsync 🙂 Comme je vais changer le disque de 8To par un plus gros, j'ai fait une copie de sauvegarde de toutes mes données du 8To ailleurs ou j'en ai déplacé sur les autres volumes du 920+. Pour les données sauvegardées ailleurs, elles ont ét...

- 4 réponses

-

- hyperbackup

- rsync

-

(et 3 en plus)

Étiqueté avec :